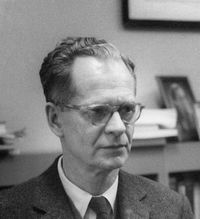

- B. F. Skinner

- Burrhus Frederic Skinner

- Skinner, B. F.

Burrhus Frederic Skinner (20.03.1904-18.08.1990) war ein amerikanischer Psychologieprofessor, der den Begriff der operanten Konditionierung prägte und experimentell erforschte. Hierzu erfand er die noch heute in der Verhaltensforschung eingesetzte Skinner Box. Sein „programmierter Unterricht“ hatte auf die US-Pädagogik des 20. Jahrhunderts so viel Einfluss, dass er Namensgeber Rektor Skinners in „Simpsons“ war.

B. F. Skinner wurde in Pennsylvania als Kind eines Anwalts in die US-Mittelschicht der Ostküste geboren. Schon in seiner Kindheit zeigte er ein reges Interesse und Talent, naturwissenschaftliche Probleme zu analysieren und sie durch automatisierte Apparate und Technik zu lösen. So baute er mit einem Freund eine Telegrafenleitung zwischen den Häusern der beiden. Überliefert ist auch, dass die beiden eine Vorrichtung ersannen und umsetzten, um reife und unreife Holunderbeeren zu trennen. Dazu nutzten sie den Umstand, dass die unreifen Beeren auf Wasser aufschwammen, während die reifen absanken. Konkret ließen sie kontinuierlich Wasser in einen Eimer laufen und gaben die Beeren hinein, sodass die reifen im Eimer verblieben und die unreifen mit dem überlaufenden Wasser aus dem Eimer gespült wurden.

Seine akademische Laufbahn begann er als Student der englischen Literatur am New Yorker Hamilton College mit dem Ziel, Schriftsteller zu werden. Nach erfolgreichem Abschluss 1926 mit dem Grad des Bachelor of Arts versuchte er einen Roman zu schreiben, was ihm nicht gelang. Um sich zu finanzieren, versuchte er sich als freier Journalist, musste aber feststellen, dass seine Artikel von den Redaktionen zu selten veröffentlicht wurden. So musste eine Arbeit in einem Buchladen übernehmen. Dort wurde sein Interesse an der Verhaltensforschung, beispielsweise durch Bücher von Pawlow, geweckt.

Infolgedessen schrieb er sich 1928 an der Harvard University ein, um Psychologie zu studieren und 1931 zu promovieren. Im Anschluss an seine Promotion forschte er bis 1936 in Harvard, um an der University of Minnesota und der Indiana Universty zu lehren, bevor er 1948 nach Harvard zurückkehrte, wo er bis zu seinem Tod im Jahr 1990 lehrend und forschend tätig blieb.

Schon in seiner Studienzeit in Harvard wurde er von einem Kommilitonen überredet, gemeinsam erste verhaltenswissenschaftliche Experimente durchzuführen und hierfür die entsprechenden Apparaturen zu entwickeln, woran Skinner schon von Kindheit an interessiert war. Dies führte zu ersten Versionen der Skinner Box und stellte seine ersten Schritte in Richtung seines wissenschaftlichen Wirkens dar, das von der Ansicht geprägt wurde, dass Verhaltenspsychologie nur dann eine Wissenschaft sein könne, wenn ausschließlich beobachtbares und messbares Verhalten betrachtet und bewertet wird, keinesfalls aber in den Bereich des Glaubens abgleitende Annahmen über Vorgänge im Inneren von Lebewesen angestellt würden. Mit dieser Ansicht begründete er den radikalen Behaviorismus als Lerntheorie. Im Gegensatz zu Konrad Lorenz verwendete er Begriffe wie Instinkt und Trieb zur Erklärung von Verhalten und Lernen nicht.

Basierend auf der Beobachtung und Messung von Reaktionen und Reizen begründete er die operante Konditionierung, deren Kernaussage ist, dass das künftige Auftreten eines Verhaltens durch die von ihm begründetend Konsequenzen abhängt. Operant nannte er das Verhalten, weil er postulierte, dass ein Lebewesen mit diesem Verhalten in seiner Umwelt operiert, um angenehme Konsequenzen zu erzeugen und unangenehme zu vermeiden. Zu den sich hieraus ergebenden und im Kontingenzschema dargestellten vier möglichen Konsequenzen unternahm er eine Vielzahl von Versuchen mit Tauben in der Skinner Box und kam so zu seinen Forschungsergebnissen.

Beispielhaft sie hier ein mögliches Experiment für die positive Verstärkung dargestell, die die Basis vieler hier detailliert beschriebener moderner Trainingsmethoden darstellt und nicht mit Prägung zu verwechseln ist: Die Skinner Box war mit einem Schalter ausgerüstet, dessen Betätigung eine automatische und sofortige Ausgabe einer gewissen Menge Futter auslöste. Die Box war so mit einer Art Drucker verkabelt, der es ermöglichte, sowohl die Anzahl der Betätigungen des Schalters zu jedem Zeitpunkt auf Papier zu drucken. Die Versuchstiere, zumeist Tauben, wurden nun in die Box gesetzt und zeigten irgendwelches Verhalten. Nach einiger Zeit, vielleicht 30 Minuten, pickten sie auf den Schalter mit der Folge, dass sie Futter bekamen und der Drucker den Grafen nach 30 Minuten von 0 Reaktionen auf 1 Reaktion anhob. Nun dauerte es wieder einzige Zeit, vielleicht 10 Minuten, bis wieder auf den Schalter gepickt wurde. Nach einigen solcher Versuche zeigte sich, dass die Tauben bald nicht mehr 30 Minuten brauchten, bis sie erstmalig auf den Schalter pickten, sondern schon nach einigen Sekunden und dass sie, nachdem sie das nun verfügbare Futter gefressen hatten, sofort wieder auf den Schalter pickten.

Bei diesem Experiment spielen vor allen Dingen die einer Reaktion (das Picken auf den Schalter) folgenden Konsequenzen in Form als angenehm empfundener Reize (Verfügbarkeit von Futter), von Skinner Verstärker genannt, eine Rolle. Sie verstärken das Auftreten eines Verhaltens. Versuche zur Wirkweise der möglichen Konsequenzen und damit auch ihre Einteilung und Definition beschäftigte ihn über mehrere Jahre: Setzte er negative Verstärkung in einer Veröffentlichung von 1938 noch mit der Strafe gleich, so unterscheidet er 1953 positive und negative Verstärkung von positiver und negativer Strafe im Rahmen des noch heute gültigen Kontingenzschemas.

Außerdem erforschte er die Wirkung von Hinweisreizen, die nach seiner Definition darauf hinweisen, dass ein bestimmtes Verhalten nun eine bestimmte Konsequenz nach sich zieht. Ein Beispiel aus dem wilden Leben eines Beutegreifers stellt sich nach Skinner wie folgt dar: Der Duft einer Hasenfährte (Hinweisreiz) zeigt an, dass das Verhalten „den Hasen jagen“ (Reaktion) durch die Verfügbarkeit von Futter (Verstärkung/Konsequenz) lohnend ist. Skinner erklärte Verhalten also als dreier-Kontingenz aus Hinweisreiz, die eine bestimmte Reaktion auslöst, da der Hinweisreiz anzeigt, welche Konsequenz diese haben wird.

Ausgehend von der Annahme, dass in freier Wildbahn nicht jedes Mal ein Verhalten verstärkt wird, entwickelte er Verstärkerpläne. Um beim Beispiel aus der Urgeschichte unserer Haushunde zu bleiben, war Skinner klar, dass nicht jede Jagd von Erfolg gekürt ist, was bedeutet, dass das Jagdverhalten nicht jedes Mal, sondern unregelmäßig verstärkt wird. Skinner erstellte nun verschiedene Verstärkerpläne und erforschte ihre Wirkung auf das Verhalten.

Im Experiment hat Skinner Verhalten als „Reaktion“ bezeichnet und in der Tat handelt es sich beim Picken auf einen Schalter um sehr einfaches Verhalten, das mit dem komplexen Verhalten, das beispielsweise eine Jagd darstellt, wenig zu tun hat. Solch komplexes Verhalten erklärt Skinner, indem er es in seine Einzelteile, also einzelne Hinweisreiz-Reaktion-Verstärkungs(Reiz)-Kopplungen zerlegt, die jeweils verkettet sind. Bei einer solchen Verkettung sind alle bis auf den letzten Verstärkungsreiz gleichzeitig Hinweisreize für die folgende Reaktion. Noch heute wird der Begriff Chaining nicht nur im Hundetraining verwendet, um komplexe Verhaltensketten zu beschreiben und zu trainieren. Als Beispiel für Chaining nochmal das komplexe Jagdverhalten: Duft der Hasenfährte (Hinweisreiz) – der Fährte folgen (Reaktion) – Hase in Sichtweite (Verstärkerreiz und Hinweisreiz) – Hase hetzen (Reaktion) – Hase in Fangnähe (Verstärkerreiz und Hinweisreiz) – Hase beißen/schlagen (Reaktion) – Futter in Form des toten Hasen verfügbar (Verstärkerreiz und Hinweisreiz) – Fressen (Reaktion) usw.

Die Überlegungen, Versuche und die Entwicklung der operanten Konditionierung und ihre konkreten Auswirkungen auf die Hundeerziehung stellen wir in unserer dreiteiligen Artikelreihe zur Lerntheorie ausführlich dar:

Lerntheorie I: Die wissenschaftlichen Grundlagen modernen Hundetrainings – Pawlow, Skinner & Co

Lerntheorie III: Der Kurzüberblick über die Trainingsmethoden der modernen Hundeerziehung

Bekannt ist Skinner aber auch für verschiedene praktische Anwendungsversuche seiner Erkenntnisse. So wurde während des 2 Weltkrieges vor der Verwendung rein elektronischer Lösungen unter seiner Leitung versucht, Tauben so zu konditionieren, dass sie eine Rakete in ein Ziel steuern können. Außerdem betätigte er sich in den 1940er Jahren doch noch als Autor und schrieb den 1948 veröffentlichten Roman „Walden 2“, in dem er Anhand einer US-Gemeinde eine Gesellschaft zeichnet, die ihre Kinder durch operante Konditionierung erzieht und so die Gesellschaft in Richtung höherer Produktivität und einem höheren Maß an persönlicher Glücklichkeit steuert. Dieser Ansatz rief viele Kritiker auf den Plan, die die Frage aufwarfen, welche Auswirkungen sein Ansatz der geplanten und gesteuerten Gesellschaft in den Händen von Staatenlenkern wie Hitler, Mao oder Stalin haben würde.

Sein bis heute währendes Andenken in Form des Grundschuldirektors Skinner in der populären Cartoon-Serie „Die Simpsons“ von Matt Groening verdankt er allerdings seinem Ansatz des programmierten Unterrichts, der Mitte des 20. Jahrhunderts im amerikanischen Bildungswesen einen großen Einfluss hatte und noch heute in modernen Lernsoftwares zur Anwendung kommt. Diese praktische Anwendung seiner operanten Konditionierung basiert auf der positiven Verstärkung. Skinner ersann hierfür eine Lernmaschine, die eine Liste mit vielen Fragen enthielt. Diese Fragen konnten in einem Fenster eine nach der anderen gelesen und beantwortet werden. Für jede richtige Antwort gab es einen Verstärker. Die Fragen wurden so gewählt, dass der Schüler eine Quote von 80 % richtiger Antworten schaffte.

Das Foto von B.F. Skinner stammt aus der Bildquelle "Wikipedia" (als Link mit der Ziel-URL https://de.wikipedia.org/wiki/B._F._Skinner). Es wird gemäß der Lizenz "Creative Commons Attribution-ShareAlike 4.0 International" (als Link mit der Ziel URL https://creativecommons.org/licenses/by/3.0/) gemeinfrei von uns verwendet, ohne von verändert worden zu sein.

- Hundetraining: Das erlernte Entspannen des Hundes mit Entspannungssignalen

- Lerntheorie I: Die wissenschaftlichen Grundlagen modernen Hundetrainings – Pawlow, Skinner & Co

- Hund & Baby - Was muss ich als Hundehalter beachten, wenn ein Baby zu Hause einzieht?

- Wilderei durch den Hund – kein Kavaliersdelikt

- Das Beutefangverhalten von Hunden

- Lerntheorie II: Clicker- & Targettraining, Shaping & Chaining, Capturing & Co als angewandte Wissenschaft

Hat dir der Inhalt gefallen? Dann teile ihn doch auch mit anderen: