Lerntheorie I: Die wissenschaftlichen Grundlagen modernen Hundetrainings – Pawlow, Skinner & Co

Vom Pawlowschen Hund, über operanten Konditionierung, Belohnung und Strafe

Von:

Ulf Weber

Zuletzt aktualisiert am: 3.3.2024

Im ersten der drei Teile über moderne Trainingsmethoden in der Hundeerziehung befassen wir uns mit der Geschichte der verhaltenswissenschaftlichen Grundlagen. Wenn Du wissen möchtest, warum wir heute Strafen vermeiden und stattdessen mit Belohnungen im Training arbeiten, im Alltag aber weder ständig belohnen müssen noch sollen, solltest Du diesen Text lesen. Er begründet, warum wir Hunden gegenüber immer konsequent sein sollten und was unter Konsequenz verstanden wird. Insgesamt gibt er Dir ein tiefes Hintergrundwissen, um selbst entscheiden zu können, nach welchen der in Teil 2 dieser Reihe dargestellten und in Beziehung zur Verhaltenswissenschaft gesetzten Erziehungsmethoden Du Deinen Hund trainieren möchtest. Wenn Du nur einen Überblick über die moderen Techniken haben möchtest, bietet sich Teil 3 an, der die Ergebnisse in aller Kürze zusammenfasst.

Pawlow & die klassische Konditionierung

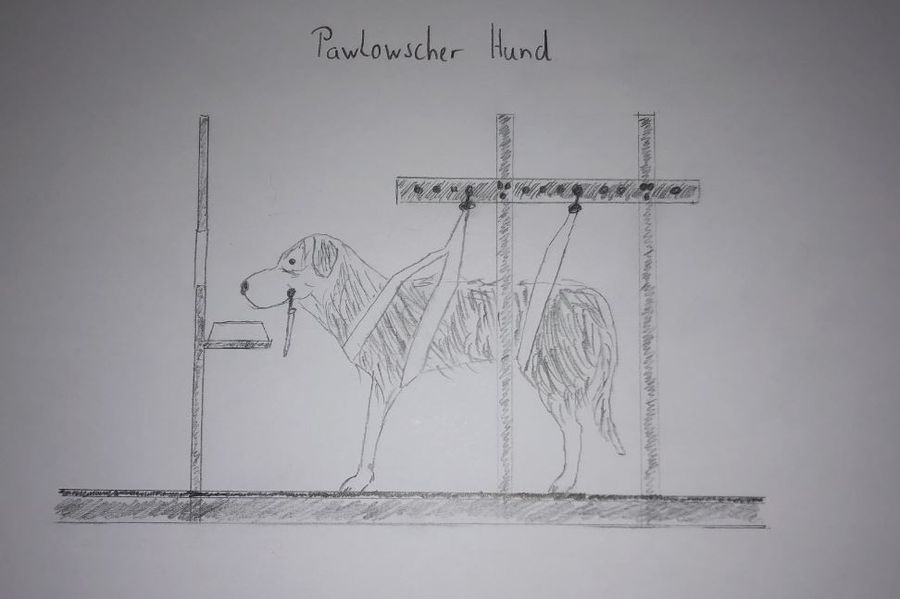

Die Geschichte der Paslowschen Hunde, die im Labor des russischen Arztes Ivan Petrovic Pawlows zu sabbern begannen, wenn sie die Schritte ihres Tierpflegers hörten, ist auch der Beginn der klassischen Konditionierung und damit einer der Grundlagen moderner Hundeerziehung.

Die Geschichte der pawlowschen Hunde

Der russische Mediziner und Physiologe Ivan Petrovic Pawlow forschte ab 1890 zur nervlichen Steuerung der Verdauungsdrüsen. Für seine durch Versuche an Hunden gewonnenen Erkenntnisse zur Steuerung der Verdauung wurde er 1904 mit dem Nobelpreis geehrt.

Im Rahmen dieser Forschungsarbeit machte er die uns Hundehaltern gut bekannte Beobachtung, dass die Laborhunde zu speicheln begannen, wenn sie Futter vorgesetzt bekamen. Seine feine Beobachtungsgabe ließ ihn aber erkennen, dass die Hunde nach einiger Zeit schon zu speicheln begannen, wenn sie nur die Schritte des Tierpflegers hörten, der gewöhnlich das Futter brachte. Er schloss daraus, dass die Hunde das Geräusch der Schritte nun mit dem Futter verbunden hatten und nun die im Grunde für Hunde bedeutungslosen Schritte nun mit Futter gleichbedeutend waren und daher dieselbe Reaktion wie das Futter selbst auslösen.

Die klassische Konditionierung oder die Reizkopplung

Im Jahr 1905 begann Pawlow, seine auf die Beobachtung seiner Laborhunde während der vergangenen 15 Jahre basierenden Vermutungen zur Reizkopplung wissenschaftlich aufzuarbeiten. Dazu stellte er seine Theorie der klassischen Konditionierung rund um das Verhältnis der folgenden unterschiedlichen Begriffe zueinander auf.

Der unbedingte Stimulus ist ein Reiz, der eine unbedingte Reaktion hervorruft. Unbedingt werden beide genannt, da die Wahrnehmung des Reizes und die Reaktionnicht gelernt werden müssen. Sie sind angeboren und die Reaktion erfolgt reflexartig, also ohne willentliche Steuerung. So ist Futter der unbedingte Reiz und der Speichelreflex die unbedingte Reaktion.

Dabei wird zwischen appetitiven oder angenehmen Reizen, wie im Falle des Futters, und aversiven oder unangenehmen Reizen unterschieden. Ein solcher aversiver Reiz wäre beispielsweise ein schmerzverursachender Stromschlag.

Ein neutraler Stimulus ist ein Reiz, den der Hund zwar wahrnimmt, der aber keine besondere Reaktion auslöst. Das trifft auf fast alles zu, was wir Menschen den Ohren und Augen unserer Hunde zukommen lassen: Worte, Gesten und Geräusche von Klickern oder Glocken. Im oben beschriebenen Fall der pawlowschen Hunde waren das zunächst die Laufgeräusche des Tierpflegers.

Aus dem neutralen Reiz wird durch die klassische Konditionierung dann ein bedingter Stimulus, der eine bedingte Reaktion auslöst, indem die beiden Reize gekoppelt werden: Die ursprünglich bedeutungslosen Geräusche wie Fußschritte, Klicker oder Worte bekommen nun für den Hund eine Bedeutung, z. B. die Erwartung, dass es gleich Futter gibt. Voraussetzung für diese Reizkopplung ist eine räumliche und zeitliche Nähe der beiden Reize. Diese Nähe wird Kontiguität genannt. Die entstandene Reizkopplung verursacht als bedingte Reaktion den Speichel-Reflex.

Die Korrektheit seiner Theorie über die Reizkopplung überprüfte er in entsprechenden Experimenten. Dabei prüfte er erst die Reaktion der Hunde auf einen neutralen Stimulus, beispielsweise das Klingeln einer Glocke oder das Ticken eines Metronoms: Nur, wenn die Hunde „unspezifisch“ reagierten, also beispielsweise nur die Ohren spitzten und sich in Richtung des Geräuschs orientierten, aber keine weiteren Reaktionen zeigten, war der Reiz tatsächlich neutral.

In der folgenden Lernphase wurden der neutrale und der appetitive Stimulus, konkret beispielsweise also das Geräusch einer Glocke und die Verabreichung von Futter, immer wieder in räumlicher und zeitlicher Nähe präsentiert, wobei diese Kontiguität auf unendlich viele Weisen hergestellt werden kann: Beispielsweise kann das Glockengeläut kurz vor der Futtergabe beginnen und dann entweder schon bei Futtergabe oder erst nach dem Fressen enden. Denkbar wäre auch, das erst geläutet wird, wenn das Futter schon gereicht ist. Pawlow teilte seine Versuchstiere nun in Gruppen ein, die dann in einer bestimmten Variante der Kontiguität konditioniert wurden.

Das Ergebnis war in vielen dieser Varianten, dass er seinen Hunden beibrachte zu speicheln, wenn sie das Geräusch einer Glocke vernahmen: Die Hunde hatten die beiden Reize gekoppelt.

Im Rahmen der Versuchsreihen wurde auch erkannt, welche Variante der Kontiguität besonders erfolgreich war und dass der neutrale Stimulus (Glockengeläut etc.) am besten und schnellsten mit dem unbedingten Reiz (Futter) verknüpft wird, um zur selben Reaktion (Speicheln) zu führen, wenn der neutrale kurz vor dem unbedingten Stimulus startet und dann gleichzeitig mit ihm weiter gegeben wird. In dem Fall spricht man von „short delayed conditioning“. Der Umstand, dass dieses „short delayed conditioning“ die effektivste und schnellste Methode ist, eine Reizassoziation aufzubauen, lässt die Wissenschaft erkennen, dass es den Lebewesen insgesamt darum geht, durch die Reizkopplung ihre Reaktionsgeschwindigkeit zu erhöhen, indem sie eben lernen, dass auf ein vorauseilendes Signal ein wichtiger Reiz erfolgt, auf den sie reagieren müssen. Somit kann schon auf das Signal hin und nicht erst auf den tatsächlichen Reiz hin reagiert werden. Der hiermit gewonnene zeitliche Vorsprung stellt einen Überlebensvorteil dar.

Pawlow stellte auch fest, dass eine hergestellte Konditionierung auch wieder abgeschwächt werden kann, nämlich dann, wenn der bedingte Reiz viele Male ohne den unbedingten Reiz gegeben wird. Auf Grund eines Übersetzungsfehlers wird hierbei von Extinktion oder Löschung gesprochen.

Die Abschwächung konnte auch nach dem zweiten Weltkrieg beobachtet werden: Menschen in häufig bombardierten Gebieten verknüpften das angsteinflößende Bombardement mit dem vorangehenden Sirenengeheul und bekamen lange Zeit nach dem Krieg schon dann Angst, wenn der Probealarm erklang. Diese Angst verlor sich aber bei vielen im Laufe der Zeit, da nach dem Alarm keine Bomben mehr fielen - die Kopplung beider Reize wurde gelöscht.

Im Grunde erkannte also Pawlow, dass ein Organismus lernen kann, einen Reiz durch einen anderen zu ersetzen und dann dieselbe Reaktion zu zeigen. Diese war zunächst eine Reflexreaktion, über die das Lebewesen keine „willentliche“ Entscheidung treffen konnte und diese angeboren und nicht zu erlernen war.

Die Klassische Konditionierung in der Hundeerziehung

Eine praktische Anwendung dieser Technik in Reinform stellt die Gewöhnung an den Klicker dar, durch die der Hund lernt, dass das Geräusch des Klickers für ihn Futter und damit etwas positives bedeutet.

In leicht abgewandelter Art aber auch bei der frühen Konditionierung auf ein Rückrufsignal, wie in "Führung - Freifolge - Hund-Mensch-Bindung, der sichere Rückruf und die Konditionierung – wie hängt das alles zusammen?" zu lesen ist. Hier ist zu bedenken, dass entsprechend der Erkenntnis der Abschwächung dem bedingten Reiz des Clickers immer eine Futtergabe erfolgen soll, damit der bedingte Reiz nicht an Stärke und Bedeutung für den Hund verliert.

Edward Lee Thorndikes Puzzle-Boxen & die Instrumentelle Konditionierung

Zur selben Zeit interessierte sich der amerikanische Psychologe Edward Lee Thorndike für Lernverhalten und entwickelte für die experimentelle Forschung seine Puzzle-Boxes. Aus den in seinen Versuchen gewonnen Erkenntnissen formulierte er die Grundlagen der Instrumentellen Konditionierung, die ebenfalls großen Einfluss auf die moderne Hundeerziehung hat.

Die Forschung Thorndikes

Der 1874 in den USA geborene Edward Lee Thorndike konzentrierte sich als Psychologe auf Verhaltensforschung, kam also im Gegensatz zum Physiologen Pawlow vom Fach und forschte seit 1898 zum Lernverhalten von Tieren. Er definierte im Rahmen seiner Forschungsarbeit drei Gesetze, die zur Grundlage der Theorie der instrumentellen Konditionierung führte. Damit beschäftigte er sich „offiziell“ zwar sieben Jahre vor Pawlow mit Verhaltensforschung, andererseits forschte Pawlow seit 1890 bereits an Hunden zu deren Verdauungsdrüsen, was bei ihm zu ersten Erkenntnissen zur Reizkopplung führte.

Es ist also nicht ganz klar, wer von beiden zeitlich der erste war. Da aber die komplexere Instrumentelle Konditionierung bereits aus der Klassischen Konditionierung bekannte Begriffe verwendet, haben wir diese als erste erklärt.

Thorndikes Forschungsziel – Wie lernt ein Lebewesen?

Thorndike wollte unter anderem herausfinden, auf welche Weise ein Organismus, also ein Tier oder Mensch, lernt.

Bei dieser Fragestellung war er sehr von Darwins Evolutionstheorie inspiriert. Diese besagt, dass die Natur zufällige Varianten einer Art entwickelt. Die Varianten, die einen lebenswichtigen Vorteil besitzen und somit besser an die durch die Umwelt gegebenen Aufgaben angepasst sind, überleben und vermehren sich. Die weniger gut angepassten, überleben seltener und vermehren sich weniger und sind vom Aussterben bedroht. Diesem „Survival oft he fittest“ liegt also das Prinzip des Versuchs und Irrtums zu Grunde: Es werden Varianten einer Art ausprobiert und die Irrtümer dabei sterben aus.

Denkbar war nun, dass sich das Prinzip des Trial and Error auch auf das Erlernen einer Reaktion durch ein Individuum anwenden ließe. Die Alternative dazu wäre ein Lernen durch plötzliche Einsicht.

Um dies erforschen zu können, musste er sich eine Versuchsanordnung überlegen, die es ihm erlaubt, ein Versuchstier vor ein zu lösendes Problem zu stellen, das als Stimulus für eine Reaktion dient. Die Lösung des Problems darf dem Tier vor Beginn der Versuchsreihe nicht bekannt sein, damit die Reaktion des Tieres darin besteht, herauszufinden und zu lernen, wie der Stimulus beseitigt werden kann.

Im Gegensatz zu Pawlows klassischer Konditionierung ging es ihm also nicht darum, wie ein Lebewesen lernt, einen Reiz durch einen anderen zu ersetzen und dann auf beide Reize gleich zu reagieren. Vielmehr ging es Thorndike darum, dass das Lebewesen lernt, auf einen Reiz hin eine bestimmte Reaktion zu zeigen.

Thorndikes Versuchsaufbau: Die auf Deutsch Problemkäfig genannte Puzzle Box

Die von Thorndike 1898 entwickelte Puzzle Box, Rätselkäfig oder Problemkäfig zu Deutsch, erfüllt die oben genannten Kriterien. Sie ist im Grunde genommen ein Käfig mit einer einfachen Vorrichtung zur Selbstbefreiung. Vor die Box wurde Futter als zusätzlicher Stimulus für das Versuchstier platziert. Die Vorrichtung zur Selbstbefreiung des Versuchstiers kann ein zu drückender Knopf, eine zu betretende Platte oder Wippe oder ein zu ziehendes Seil sein.

Als Labortiere verwendete er vorwiegend Hühner, Hunde und Katzen. Zum Zeitpunkt des Versuchs musste das jeweilige Tier hungrig sein, damit es das Ziel verfolgt, aus dem Käfig zu entkommen und zum Futter zu gelangen.

So waren die Tiere mit drei Stimuli oder Problemen konfrontiert:

a. Entzug der Freiheit als äußerer Reiz

b. leerer Magen als innerer Reiz

c. Futter, das sie wahrnahmen, das aber wegen des Freiheitsentzugs nicht leicht zu erreichen war, als äußerer Reiz.

Diese Probleme oder Stimuli verursachen bei den Tieren eine Vielzahl verschiedener Reaktionen oder Verhaltensweisen. Nun geht es für die Tiere darum, die erfolgreiche Verhaltensweise oder Reaktion zu finden, die das Problem löst und den Käfig öffnet und außerdem zu lernen, welche der Verhaltensweisen zuverlässig und damit immer das Problem löst.

Wie liefen die Versuche Thorndikes ab?

Thorndike sperrte nun ein hungriges Tier in die Puzzle Box, um das Verhalten des jeweiligen Tiers zu beobachten und zu dokumentieren. Wurde ein Tier erstmalig in den Käfig gesetzt, bewegte es sich erwartungsgemäß auf zufällige Art und Weise, um dem Käfig zu entkommen. Ebenso zufällig kann hierbei auch der Mechanismus zur Selbstbefreiung betätigt werden, was je nach Anordnung und daraus folgendem Schwierigkeitsgrad nicht jedem Tier gelungen ist.

Thorndike maß nun die in vielen Fällen recht lange Zeit, die das Tier benötigte, um sich zu befreien und wiederholte das Ganze mehrfach. So konnte er die Zeiten, die bei den jeweiligen Durchläufen des Versuchs erzielt wurden, miteinander vergleichen und eine sogenannten Lernkurve erstellen. Anhand dieser Lernkurve wiederum konnte abgelesen werden, ob die Tiere überhaupt lernen und wenn ja, ob das Lernen mit einem Aha-Moment der Einsicht verbunden ist oder über Versuch und Irrtum und damit graduell in einer sanften Kurve erfolgt.

Würde gar nicht gelernt, dürfte die benötigte Zeit im Laufe der Versuchsdurchgänge nicht kürzer werden: In statistisch immer gleichen Zeitintervallen würde aus Zufall der Mechanismus ausgelöst werden.

Bei einem Aha-Moment hätte die für die Selbstbefreiung benötigte Zeit vom ersten Durchlauf bis zu dem Durchlauf mit dem Aha-Moment gleich lang bleiben müssen, um dann sprunghaft auf eine viel kürzere Spanne zu sinken, die dann immer gleichbliebe.

Tatsächlich stellte Thorndike aber fest, dass im Durchschnitt aller Versuchstiere die Zeiten, die für die Selbstbefreiung benötigt wurden, von Durchgang zu Durchgang kürzer wurden. Dies erfreute Thorndike sicher sehr, scheint diese Art zu lernen doch demselben Prinzip zu folgen, wie die ihn zu seiner Forschung inspirierende Evolutionslehre seines Vorbilds Charles Darwin.

Im Falle der Katzen stellte er darüber hinaus fest, dass sie das Futter gar nicht wahrnahmen, wenn sie in den Käfig gesperrt waren. Diese Tiere sind so freiheitsliebend, dass der Freiheitsentzug als unangenehmer Reiz völlig ausreicht und sie dem Käfig entkommen möchten, weil es ihnen Unbehagen bereitete, auf solch engem Raum eingesperrt zu sein. Sie bissen und krallten alles im Käfig an, wohl in der Hoffnung, den Käfig so kaputt machen, entkommen zu können und letztlich den aversiven Reiz beenden zu können. Wie wir im im folgenden Block über die Entstehung der operanten Konditionierung sehen werden, entspricht das einer negativen Verstärkung.

Was schloss Thorndike aus seinen Versuchen?

Die drei wesentlichen theoretischen Erkenntnisse, die er aus seinen Beobachtungen und Messungen gewann, bilden die Grundlage für die Instrumentelle Konditionierung.

Das Gesetz der Übung:

Aus der Tatsache, dass die Versuchstiere mit jeder Wiederholung der Selbstbefreiung schneller wurden, schloss er, dass ein zu erlernendes Verhalten vielfach wiederholt werden muss, also geübt werden muss, um es sicher zu lernen.

Dass es sich tatsächlich so verhält, wissen wir nicht nur aus unserer Schulzeit, in der wir an uns selber beobachten konnten, dass wir beispielsweise erst durch wiederholtes Aufsagen des kleinen Einmaleins aus dem Stegreif wussten, was 3 x 6 oder 6 x 7 ergibt. Auch bezogen auf sportliche Bewegungsabläufe wissen wir, dass Übung den Meister macht.

Klar, dass das auch so für unsere Hunde gilt: Eine hohe Anzahl von Wiederholungen sichert, dass Dein Hund versteht, was Du wann von ihm willst.

Gesetz der Bereitschaft:

Thorndike experimentierte vorwiegend mit Hühnern, Hunden und Katzen.

Er konnte beobachten, dass Katzen auch ohne vor dem Käfig platziertem Futter nach Freiheit strebten, während die hungrig gehaltenen Hühner und Hunde vor allem nach dem vor dem Käfig platzierten Futter strebten und ohne das vor dem Käfig platzierte Futter nicht im selben Maß versucht hatten, sich zu befreien.

Er schloss daraus, dass für das Erlernen neuen Verhaltens, in dem Fall das der Selbstbefreiung aus dem Käfig, eine Bereitschaft vorliegen muss. Diese Bereitschaft zu lernen ergibt sich aus einem Bedürfnis, das der lernende Organismus nur befriedigen kann, wenn er lernt und das sich seinerseits aus einem Reiz oder Stimulus ergibt: Die Katze hat das Bedürfnis nach Freiheit, die anderen Tiere hatten das Bedürfnis zu fressen. Beide Bedürfnisse konnten nur befriedigt werden, wenn die Tiere lernten, sich zu befreien.

Ein Organismus wird also nach Thorndikes Meinung nur dann bereit oder motiviert sein, neues Verhalten zu lernen, wenn er ein erfolgreiches Instrument zur Verbesserung seiner Situation oder zur Lösung eines Problems sucht.

Thorndike betrachtet also das Verhalten eines Lebewesens als Instrument zur Herstellung eines für das Lebewesen möglichst angenehmen Zustands. Dieser Denkansatz war wohl für Prof. Dr. Gerd Mietzel ausschlaggebend, diesen Ansatz als Instrumentelle Konditionierung zu definieren.

Gesetz der Auswirkung:

Wenn Thorndike also sagt, dass alles Verhalten eines Lebewesens ein Instrument zur Befriedigung von Bedürfnissen und damit zur Lebensverbesserung ist, liegt es nahe, dass Auswirkung des Verhaltens eine wesentliche Rolle spielt.

In seinen Experimenten konnte er beobachten, dass die Verhaltensweisen, die den Käfig nicht öffneten und daher kein positives Ergebnis brachten, seltener von den Tieren ausprobiert wurden. Auf diese Weise schafften es die Tiere im Laufe der Zeit, viele nicht erfolgreiche Verhaltensweisen gar nicht mehr zu versuchen und dadurch die Zeit, die sie brauchten, sich zu befreien, zu senken. Übrig blieb dann nur die erfolgreiche Verhaltensweise, die dann früher und vor allem öfter verwendet wurde.

Thorndikes Gesetz der Auswirkung besagt also, dass jedes Lebewesen bestrebt ist, Verhaltensweisen zu lernen, die ein Problem lösen und denen somit angenehme und belohnende Konsequenzen folgen. Umgekehrt geht Thorndike davon aus, dass es lernen will, Verhaltensweisen zu vermeiden, die die Situation nicht verbessern oder gar verschlimmern, denen also negative und somit bestrafende Konsequenzen folgen.

Die Instrumentelle Konditionierung zusammengefasst

Thorndike sagt also zusammengefasst, dass ein Lebewesen dann bereit zu lernen ist, wenn es einem Stimulus ausgesetzt ist, den es als unangenehm und daher als zu lösendes Problem ansieht.

In dem Fall wird es eine Reaktion in Form verschiedener Verhaltensweisen ausprobieren. Viele dieser Verhaltensweisen führen zu keinem angenehmeren Zustand, sind also Fehler, und werden daher weniger stark mit der Situation in Verbindung gebracht. Dieses Prinzip wird Trial and Error, also Versuch und Fehler, genannt.

Zufällig wird aber eine dieser Verhaltensweisen die Lösung und somit einen angenehmeren Zustand bringen. Der angenehme Reiz, der von dieser Verbesserung ausgeht, wirkt als die Belohnung und damit als Verstärker der entsprechenden Verhaltensweise, die daher stärker mit der Situation verbunden wird. Daher steigt die Wahrscheinlichkeit, dass sie in ähnlicher Situation erneut versucht wird.

Noch hat das Lebewesen aber nicht eindeutig gelernt, welche Verhaltensweise erfolgreich war, obwohl eine leichte Verbindung zwischen dem Problem und der lohnenden Verhaltensweise entstanden ist. Tritt das Problem aber häufig genug auf, wird es also häufig genug geübt, wird die Verbindung zwischen Problem und der Befriedigung bringenden Lösung immer enger und dem Lebewesen immer klarer, welches Verhalten die Lösung brachte. Das bedeutet, dass häufiges Üben einer Situation das Lernen befördert.

Was bedeutet das für die Hundeerziehung?

Einleuchtend ist, dass häufige Wiederholungen von Übungen auch im Hundetraining sinnvoll sind.

Zu überdenken ist allerdings, dass die Instrumentelle Konditionierung voraussetzt, dass der Hund als Stimulus ein Problem benötigt und dann mit seinem Verhalten versucht, dieses Problem zu lösen. Das führt dazu, dass die Lösung des Problems auch gleichzeitig die das Verhalten verstärkende Belohnung darstellt. Damit kann also erklärt werden, wie ein Hund lernt, sich zu kratzen: Es juckt ihn und wenn er sich an der entsprechenden Stelle kratzt, bringt das Kratzen Erleichterung. Sicherlich kann Dein Hund so auch lernen, welche Verhaltensweisen seinen Hunger stillen:

Dich bettelnd anschauen, wenn Du am Tisch sitzt:

Bekommt er was, wird er häufiger betteln

Bekommt er nichts, wird er seltener betteln

Es wird aber nicht klar, wie Du Deinem Hund den Grundgehorsam über diese Methode beibringen kannst: Es fällt mir kein Weg ein, wie Du Dein Problem, beispielsweise Deinen Wunsch, dass Dein Hund zu Dir kommt, zu seinem Problem machen kannst. Sein Problem im Sinne Thorndikes würde schließlich bedeuten, dass das Herankommen Lösung wäre, die die Situation Deines Hundes so verbessert, sodass beide Verhaltensweisen jeweils „selbstbelohnend“ werden. Solche Situationen werden zwar vorkommen, vielleicht kommt Dein Hund immer zu Dir gelaufen, wenn er Angst hat und daher Schutz bei Dir sucht. Aber einen sicheren Rückruf hast Du dann immer noch nicht: Dein Hund kommt zu Dir, wenn er darin eine Lösung sieht, nicht, wenn Du das möchtest.

Vielleicht hatte der US-amerikanische Psychologe B. F. Skinner ähnliche Gedanken, als er an Thorndikes Arbeit anschloss und sich dabei zunächst auf das Gesetz der Auswirkung konzentrierte und in seinen Versuchen auf ein zu lösendes Problem verzichtete.

B. F. Skinner & die Anfänge der operanten Konditionierung

Die operante Konditionierung B. F. Skinners legte das Fundament nicht nur der modernen Hunderziehung. Wie er die positive Verstärkung erforschte und was seine Bedeutung für die Pädagogik des letzten Jahrhunderts mit der TV-Serie "Die Simpsons" zu tun hat, zeigen die folgenden Passagen.

Wer war B. F. Skinner?

Als Pawlow und Thorndike mit ihren Forschungen zur Konditionierung begannen, war noch nicht abzusehen, wie groß der Einfluss des 1904 in den USA geborenen Burrhus Frederic Skinners durch die von ihm entwickelte operante Konditionierung auf die Lerntheorie und die angewandte Pädagogik in der Mitte des letzten Jahrhunderts werden würde.

B. F. Skinner wurde im Rahmen seiner Arbeit in einer Buchhandlung auf die in der Zeit seiner Geburt entwickelte Klassische Konditionierung aufmerksam. Das Thema erschien ihm so spannend, dass es ihn zu einem Studium der Psychologie inspirierte und er sich 1928 zu diesem Zweck an der Harvard University einschrieb. Dort wird er auch mit der Forschungsarbeit Thorndikes in Berührung gekommen sein, die er dann vorantrieb und modifizierte, unter anderem mit der Weiterentwicklung der Puzzle Box Thorndikes zur Skinner Box.

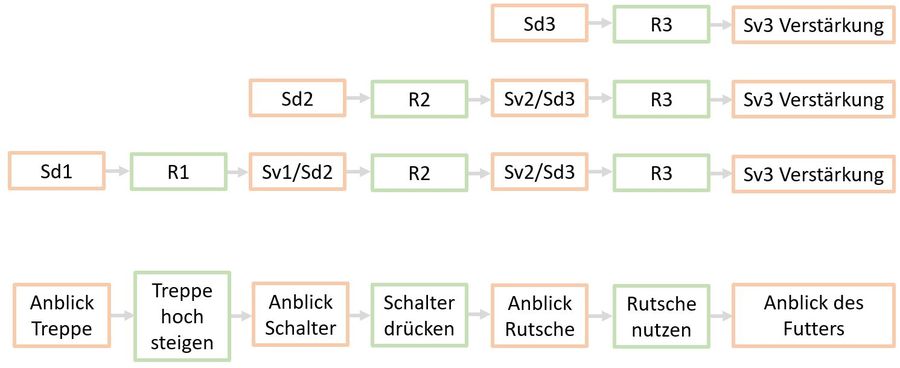

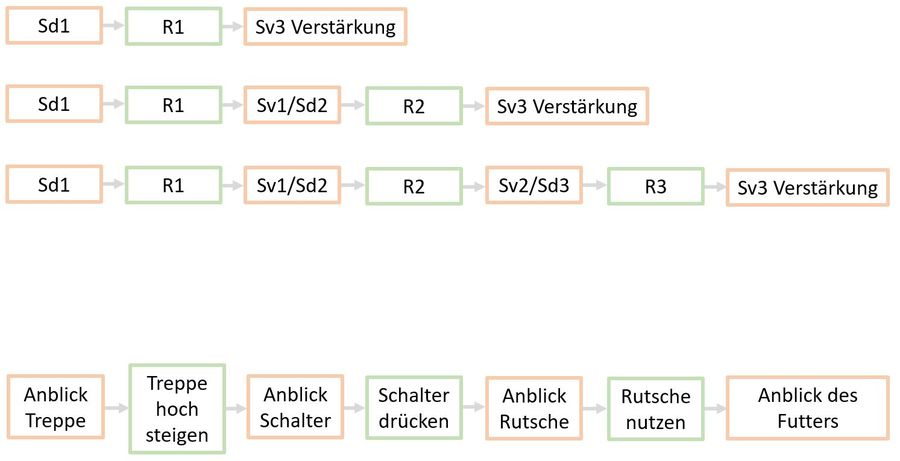

Die im Folgenden beschriebene operante Konditionierung ist ein breites und thematisch tiefes Feld: Skinner beschäftigte sich zunächst mit dem, was er positive Verstärkung nannte. Das führte ihn zu Experimenten zur negativen Verstärkung sowie der positiven und negativen Bestrafung, die er im Kontingenzschema zusammenfasste. Weiterhin erforschte er, ob es Hinweisreize gibt, die ein Verhalten auslösen können ebenso, wie die Frage, welche Auswirkung es hat, wenn eine Verstärkung nicht auf jedes gewünschte Verhalten erfolgt und entwarf dazu Versuche zu Verstärkungsplänen. Zur schnelleren Konditionierung entwickelte er das Shaping und für komplexere Verhaltensweisen das Chaining, beides Trainingsmethoden, die heute noch im Tier- und Hundetraining angewendet werden.

Skinner krönte seine Forschung mit der Entwicklung des programmierten Unterrichts, der in der Mitte des letzten Jahrhunderts immensen Einfluss auf die Pädagogik hatte. Die dadurch erreichte Bekanntheit Skinners, zeigt sich in der Tatsache, dass Matt Groening in der Comic Serie „Die Simpsons“ den Rektor von Springfields Grundschule, Seymour Skinner, nach ihm benannte und Skinner daher auch heute noch vielen Simpsons-Fans ein bekannter und mit dem Schulwesen verbundener Name ist.

In seinem 1948 veröffentlichten Roman „Walden Two“ entwarf er die Vision einer, durch positive Verstärkung, auf moralisch einwandfreies Zusammenleben konditionierten aber damit auch gesteuerten Gesellschaft. Dieser Ansatz rief viele Kritiker auf den Plan, die den mit der Menschenwürde verbundenen freien Willen in Gefahr sahen. Dieser philosophische Aspekt der Konditionierung fand durch Stanley Kubriks Film „The Clockwork Orange“ Einzug in die Populärkultur. Dort wird der extrem gewalttätige Protagonist Alex durch klassische Konditionierung an weiteren Gewalttaten gehindert. Wird hier noch ein durchaus sinnvoller Zweck vorausgesetzt, stellt sich aber auch die Frage, wer denn in einer solchen Gesellschaft die zu verstärkenden Verhaltensweisen und Werte festlegen würde: Diktatoren wie Hitler, Stalin oder Mao hätten sicherlich an diesen Techniken ihren Spaß gehabt.

Skinner war dabei immer wichtig, dass Verhaltenspsychologie streng wissenschaftlich betrieben wird. Für ihn bedeutete das, dass nur Aussagen über messbare Größen getroffen werden können. Entsprechend werden innere Vorgänge wie Gedanken oder Gefühle von ihm nicht beachtet, sondern in eine unergründliche Black-Box verbannt. So konnte er auch in Interviews auf kritische Nachfragen zu den oben genannten moralischen Fragen gelassen antworten, dass die Wirkung der operanten Konditionierung nun einmal wissenschaftlich bewiesen wäre und die Konditionierung jedes Verhalten formen würde, dabei aber nichts dafür könne, wer sie mit welchem moralischen Grundgerüst anwende.

Teilweise wurden die Frage experimentell von Skinner selbst, teilweise aber auch von seinen Kollegen oder auch von späteren Forschergenerationen beantwortet. Da die Fragen und damit die folgenden Experimente teilweise parallel stattfanden, aber teilweise eben nicht mehr von Skinner, sondern seinen Nachfolgern durchgeführt wurden, berufe ich mich im Folgenden häufig auf Skinner, wenn es um die Anfänge geht. Zum leichteren Verständnis des komplexen Themas fasse ich aber den aktuellen Stand der Forschung zusammen, auch wenn hier nicht nur Skinners Erkenntnisse einfließen.

Die Forschung Skinners und die positive Verstärkung

Zunächst befasste sich Skinner mit dem, was er später positive Verstärkung nennen würde und was heute die weitverbreitetste Grundlage für Tiertrainingsmethoden ist.

Skinners Forschungsziel – Wie lehrt man ein Lebewesen?

Skinner befasste sich sowohl mit der klassischen Konditionierung Pawlows als auch mit Thorndikes (instrumentellen) Konditionierung. Beide befassen sich mit dem lernenden Organismus.

Im Falle der klassischen Konditionierung wird gelernt, einen eigentlich bedeutungslosen Reiz einem wichtigen Reiz gleichzusetzen und auf beide mit demselben Reflex zu reagieren.

Die instrumentelle Konditionierung beschreibt, wie ein Organismus lernt, seine Reaktion auf einen äußeren Reiz anzupassen. Um überhaupt lernwillig zu sein, muss eine Lernbereitschaft hergestellt werden. Daher darf der äußere Reiz für den lernenden Organismus nicht angenehm sein, sondern muss ein Problem darstellen. Der Organismus wird durch dieses Problem, das er lösen möchte, motiviert zu lernen. Das richtige Verhalten wird belohnt, oder, wie die Forscher sagen, verstärkt, durch die Verbesserung der Lebenssituation des Lernenden: Die problemlösende Reaktion oder Verhaltensweise wird verstärkt, indem das Problem wegfällt und ist damit selbstbelohnend. Damit kann also gut beschrieben werden, wie ein Organismus in einer mit problematischen Reizen angefüllten Umwelt zu überleben lernt. Beispielweise, wie er erfolgreich auf einen Rivalen reagieren kann oder wie eine Jagd erfolgreich aufzubauen ist, wenn er hungrig ist.

Wie wir festgestellt haben, fällt es uns und wohl jedem Lehrer aber schwer, zu jedem Lerninhalt (Hier, Sitz, Platz, Fuß etc. im Falle unserer Hunde) ein Problem für den lernenden Organismus zu konstruieren. Thorndikes Theorie lässt also die Frage offen, wie denn ein Lehrer oder Trainer in das Modell passt, vor allem, wenn dieser Verhaltensweisen vermitteln möchte, die kein nahe liegendes Problem für den lernenden Organismus lösen.

Skinner wollte nun herausfinden, ob die „Effektivität der Außenkontrolle“ gesteigert werden kann. Da nach seiner Meinung zu den inneren Vorgängen oder Zuständen wie Hunger, Leid, Langeweile oder Motivation nur Spekulationen angestellt werden können, lässt er diese Aspekte in seinen Überlegungen und Ansätzen außen vor. Stattdessen werden nur Reaktionen und Reize, die im Fall der positiven Verstärkung die appetitiv/angenehm wirkenden Auswirkungen der Reaktionen darstellen, einzeln betrachtet und messbar gemacht.

In der Praxis geht es hierbei also um Kontrolle oder den Einfluss eines Lehrers oder Trainers auf den Lernenden, also die Funktionsweise des Lehrens. Ansetzen wollte er hier vor allem bei Thorndikes Gesetz der Auswirkung. Hierbei ging es vor allem um den Effekt eines dem immer noch als „Reaktion“ bezeichneten Verhalten nachgelagerten Reizes, der angenehm/appetitiv oder unangenehm/aversiv auf den lernenden Organismus wirken kann. Insofern kann auch gesagt werden, dass der Lehrer die Umwelteinflüsse des Lernenden weitgehend kontrollieren und steuern muss, wenn er Lehren möchte. Am Ende dieses Prozesses steht Skinners Theorie vom programmierten Unterricht für Kinder, bei dem die positive Verstärkung automatisiert erfolgt.

In unzähligen unterschiedlichen Versuchen mit Tieren gemessene Zusammenhänge zwischen der Auftretenswahrscheinlichkeit eines bestimmten Verhaltens und der ebenso bestimmten Konsequenzen daraus übertrug er in Fachsprache, um damit das Verhalten von Tieren und auch Menschen zu beschreiben.

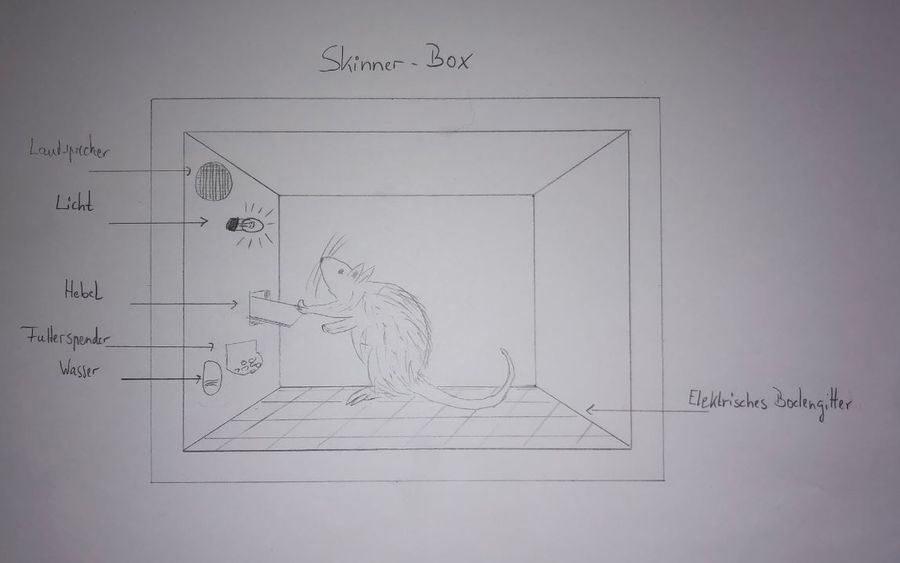

Skinners Versuchsaufbau für die positive Verstärkung: Die Skinner Box

Um Versuche zur positiven Verstärkung machen zu können, bei denen Reize kontrolliert verabreicht und die entsprechenden Reaktionen einzelner Organismen ohne weitere Einflussgrößen beobachtet und gemessen werden können, entwickelte Skinner die Problem Box Thorndikes weiter. Wichtig war dabei, dass das „Problem“ aus Thorndikes Versuchen entfiel: Skinner baute deshalb einen „reizarmen“ Käfig. Reizarm bedeutet, dass eben keine vor dem Käfig aufgestellte Futterration als auslösender Reiz für eine Reaktion verwendet wurde, wie dies noch Thorndike machte. Aber, genau wie Thorndike, platzierte auch Skinner immer nur ein Versuchstier in der Box, damit nicht die Probanden sich gegenseitig beeinflussen. Dieser Käfig bestand auch nicht aus Draht, sondern war weitgehend geschlossen und wurde später als Skinner Box bekannt.

Das war allerdings nicht das einzige wegweisende Merkmal der Skinner Boxen, die mit allerlei automatischer Technik ausgerüstet wurden. Zum einen versah er sie mit einer Futterschale, in die von außen über eine automatische Vorrichtung in Reichweite des Versuchstiers gebracht und wieder entfernt werden konnte. Diese automatische Vorrichtung wiederrum konnte das Versuchstier von innen durch das zu lernende Verhalten auslösen.

Außerdem war die ganze Apparatur mit einer Messeinheit verbunden, die sowohl die verstrichene Zeit als auch die Anzahl der „richtigen“ Reaktionen dokumentierte, um die Lernkurve messen und darstellen zu können.

Skinner verwendete als Versuchstiere vor allen Dingen Tauben, aber auch Ratten und andere an Käfighaltung gewöhnte Tiere. Der Vorteil dieser Tiere lag darin, dass der Aufenthalt in diesen Käfigen und der damit verbundene Freiheitsentzug nicht als solches schon einen problembehafteten Reiz lieferte. Vor den eigentlichen Versuchen maß er bei normaler Ernährung deren Gewicht, um nach einiger Zeit die Futterrationen so zu kürzen, dass die Tiere zum Zeitpunkt der Versuchsreihe nur noch 80 % ihres eigentlichen Gewichts wogen. Dies sollte sicherstellen, dass sie die Gabe von Futter als einen angenehmen Reiz empfanden.

Nun kann man sagen, dass der daraus resultierende Hunger ja doch wieder ein Problemreiz ist. Bei beiden, Thorndike und Skinner, dient der Hungerreiz dazu, dass das gereichte Futter auch tatsächlich als angenehmer Reiz empfunden wird.

Der Unterschied zwischen Thorndikes Puzzle-Box und der Skinner-Box liegt allerdings darin, dass der Freiheitsentzug der eigentliche Problemreiz bei Thorndike ist und davon ausgegangen werden kann, dass jedem Versuchstier schnell klar wird, dass es aus dem Käfig raus muss, um an das Futter zu kommen. Die Versuche Skinners vermeiden aber durch die Auswahl der Tiere und die Tatsache, dass das Futter innerhalb des Käfigs verfügbar gemacht wird, dass der Freiheitsentzug zu einem Problemreiz aufgebaut wird.

Im weiteren Verlauf seiner Forschung wurden die Skinner-Boxen komplexer, wie wir noch sehen werden.

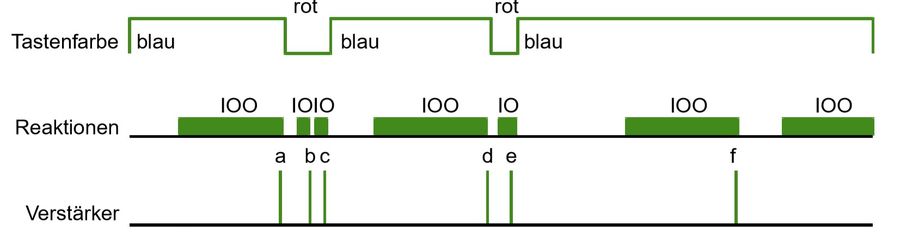

Wie liefen die ersten Versuche Skinners zur positiven Verhaltensverstärkung ab?

Nun nahm er seine Versuchstiere und setzte sie wiederholt einzeln in eine der Boxen und ließ sie sich frei bewegen und dokumentierte ihr verhalten. In einem ersten Schritt wurde gemessen wie oft die Tiere das gewünschte Verhalten in einem gewissen Zeitraum zeigen, wenn diesem Verhalten keine Futtergabe folgt. Ohne irgendeinen besonderen Reiz zeigten die Tauben diverses Verhalten. Unter anderem begannen sie, mit ihren Schnäbeln den Boden und die Wand zu bepicken. Dabei pickten sie irgendwann auch auf den Auslöser für den Mechanismus, der diese Tatsache vermerkte. So konnte Skinner die Auftretenswahrscheinlichkeit des gewünschten Verhaltens ohne Verstärkung bestimmen. Diese Auftretenswahrscheinlichkeit wird Basisrate oder Baseline genannt.

Im nächsten Schritt werden die Tiere nun wieder in die Box gesperrt und verhalten sich, wie schon zuvor. Allerdings wird durch das Picken auf den Schalter nun nicht mehr nur der Mechanismus zur Dokumentation ausgelöst, sondern es wurde auch die als positive Verstärkung dienende Futterschale in Reichweite des Tieres gebracht.

In der Folge aus wiederholten Versuchen wurde beobachtet, dass im Laufe der Zeit die Tiere den Auslöser häufiger betätigten und somit auch häufiger Futter bekamen, als im ersten Durchlauf, als es noch kein Futter als Verstärker gab.

Da es in der Skinner Box keine anderen Reize oder Einflüsse gab, war offensichtlich, dass die Tiere lernten, positiv verstärktes und somit lohnendes Verhalten häufiger zu zeigen, auch wenn sie kein offensichtliches Problem zu lösen haben.

In einem letzten Schritt prüfte Skinner, ob die schon aus der klassischen Konditionierung bekannte Löschung auch hier eine Rolle spielt. Zu diesem Zweck wurde die Skinner Box so modifiziert, dass sie zwar weiterhin die Zeit und das Picken gemessen und aufgezeichnet wurde, aber kein Futter mehr für das richtige Verhalten verabreicht wurde. Damit war sie wieder in dem Zustand, den sie auch im ersten Schritt hatte. So konnte gezeigt werden, dass nun zunächst die Verhaltensweise deutlich häufiger gezeigt wird, als vor der Konditionierung. Da aber keine Verstärkung mehr erfolgt, nimmt nach kurzer Zeit die Auftrittswahrscheinlichkeit des konditionierten Verhaltens in einem gewissen Muster stark ab: Das Verhalten wird nicht für eine gewisse Zeit nicht mehr gezeigt, wenn keine Verstärkung erfolgt. Nach einiger Zeit kommt es zu der sogenannten Spontanerholung, bei der das Verhalten erneut einige Male gezeigt wird, um zu prüfen, ob es doch noch eine Verstärkung gibt, um dann wieder in eine Phase ohne das Verhalten überzugehen. Im Laufe der Zeit werden die Phasen ohne das Verhalten größer und entsprechend sinkt die Auftrittswahrscheinlichkeit des entsprechenden Verhaltens.

Welche Schlüsse ergaben sich aus Skinners Versuchen zur positiven Verstärkung?

Der appetitive (angenehme) Reiz, der von dem Futter ausgeht, wurde von Skinner „positiver Verstärker“ genannt. Hierbei ist ihm wichtig, dass ein Reiz immer nur dann ein Verstärker ist, wenn das ihm vorangegangene Verhalten so beeinflusst wird, dass es künftig häufiger gezeigt wird, also die Auftrittswahrscheinlichkeit des Verhaltens steigt. Positiv wird der Reiz dadurch, dass er nach dem Verhalten beginnt oder erscheint.

Skinner wusste nun also, dass die positive Verstärkung funktioniert, auch wenn kein „Problemreiz“ den Organismus motiviert, überhaupt aktiv zu werden. Allerdings erkannte er auch, dass das konditionierte Verhalten schnell wieder gelöscht wird, wenn die Verstärkung wegfällt.

Diese Erkenntnisse warfen neue Fragen auf, die Skinner zu weiterer Forschung inspirierten, wie wir im Folgenden sehen werden. Daneben gibt es aber auch Anlass zur Kritik an Skinner, stellt doch seine Definition eines positiven Verstärkers einen Zirkelbezug her. Diesen Punkt werden wir in Block 6 dieses Artikels und in diesem Block des zweiten Teils dieser Serie über die praktische Hundeerziehung wieder aufgreifen.

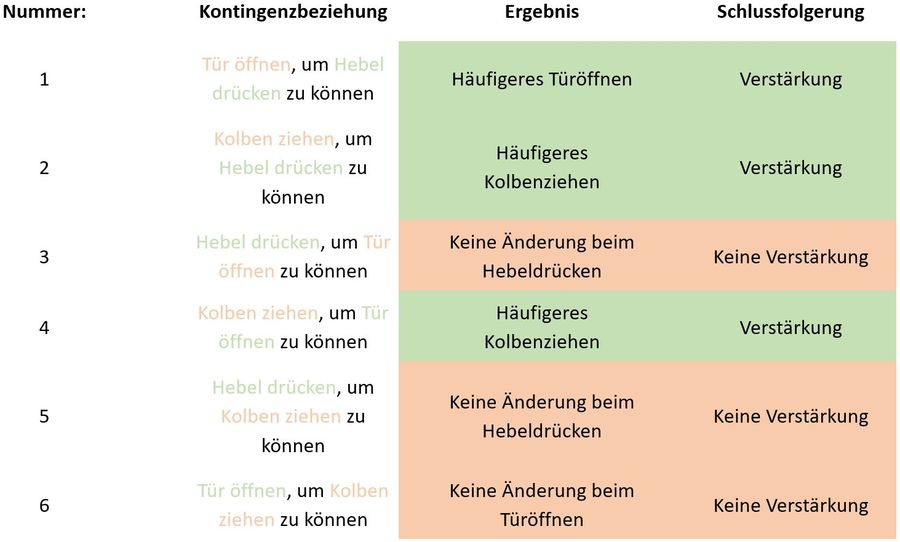

Die Forschung Skinners zu negativer Verstärkung und Bestrafungen sowie dem Kontingenzschema

Skinner war klar, dass es nicht nur appetitive Reize gibt, sondern auch aversive, also unangenehm empfundene. Außerdem konnten beide Arten von Reizen als Konsequenz eines Verhaltens beginnen oder enden. Der Begriff der Kontingenz entstammt dem Lateinischen und wird mit „Möglichkeit“ übersetzt. Skinner ging es bei diesem Begriff also darum, dass eine Reaktion oder klarer: ein zu konditionierendes Verhalten mit 100%iger Sicherheit, also der sichersten Möglichkeit, die Gabe oder den Wegfall eines bestimmten Reizes vorhersagt, da diese Konsequenz der Reaktion immer folgt.

Skinners Forschungsziel – Wie wirken aversive und appetitive Reize, wenn sie nach einem Verhalten entweder enden oder beginnen?

Skinner fragte sich nun, welche Beobachtungen gemacht werden können, wenn als Konsequenz eines Verhaltens statt des bei der positiven Verstärkung üblichen appetitiven Reizes ein aversiver Reiz gegeben wird. Zu untersuchen war auch, welche Auswirkungen es auf das Verhalten hat, wenn ein appetitiver oder ein aversiver Reiz vor dem Verhalten vorhanden ist, aber durch das Verhalten beendet wird. Die sich hieraus ergebenden weiteren drei Möglichkeiten, zu denen Versuche gemacht werden mussten, gibt die folgende Tabelle wieder und werden der Reihe nach erläutert:

| Auf das Verhalten folgender Reiz... | ...ist unangenehm/aversiv (Strom im Boden der Skinner-Box) | ...ist angenehm/appetitiv (Futtergabe) |

| ...endet oder beginnt erst gar nicht | 1 | 2 |

| ...beginnt | 3 |

positve Verstärkung |

Da Skinner bei seinen Versuchen zur positiven Verstärkung auch sofort geprüft hat, ob und wie der Prozess der Löschung verläuft, wenn die Verstärkung nicht mehr in Folge des Verhaltens gegeben wird, stellt sich sofort eine weitere Frage: Wie wird sich die unterschiedliche Verwendung appetitiver und aversiver Reize auf die bei der positiven Verstärkung beobachtete Löschung auswirken?

Der Versuchsaufbau: Adaptionen der Skinner Box

Leider ist nicht jeder Versuch oder jede Versuchsreihe, die Skinner durchführte, heute einfach recherchierbar. Jedoch zeigen die Inhalte der von Skinner und seinem Wissenschaftlerteam entwickelten operanten Konditionierung, welche Art von Versuchen sie durchgeführt haben müssen.

Um Versuche mit aversiven Reizen durchführen zu können, musste Skinner seine Box so adaptieren, dass sie einen solchen Reiz zur Verfügung stellen kann. Er versieht sie daher zusätzlich mit einem metallenen Boden, der elektrischen Strom leiten kann. Er tat dies in der Annahme, dass der leichte elektrische Strom als unangenehm und damit aversiv empfunden werden wird.

Da es andererseits auch darum geht, Reize in einer Versuchsreihe durch ein Verhalten enden zu lassen, während sie in einer anderen Versuchsreihe durch das Verhalten beginnen, wurden die Boxen so verdrahtet, dass die Reize entweder durch ein Verhalten ausgelöst oder beendet wurden. Im Folgenden werden wir uns die denkbaren Versuche im Einzelnen ansehen.

Wie liefen die Versuche Skinners zu negativer Verstärkung ab?

| Auf das Verhalten folgender Reiz... | ...ist unangenehm/aversiv (Strom im Boden der Skinner-Box) | ...ist angenehm/appetitiv (Futtergabe) |

| ...endet oder beginnt erst gar nicht | negative Verstärkung | 2 |

| ...beginnt | 3 | positve Verstärkung |

Auf das Verhalten folgender Reiz...Um die Auswirkung des Wegfalls eines unangenehmen Reizes auf das Verhalten im Experiment zu ergründen, wurden einerseits die Tauben verwendet, die zuvor für die Experimente zur positiven Verstärkung eingesetzt wurden und deren konditioniertes Verhalten gelöscht war. Eine zweite Gruppe hatte noch an keinen Experimenten teilgenommen und ist noch nie darauf konditioniert worden, auf die Schaltfläche zu picken. Genau wie schon bei den Versuchen zur positiven Verstärkung, wurden in einem ersten Schritt die Versuchstauben in die Box gesetzt, ohne, dass irgendwelche weiteren Reize verabreicht wurden, um so die Baseline des Verhaltens zu ermitteln.

Im zweiten Schritt wurde die Skinner Box so konfiguriert, dass im Boden ein leichter, aber dennoch unangenehmer und damit als aversiver Reiz empfundener Strom floss. Dieser konnte von dem Versuchstier durch ein bestimmtes Verhalten, beispielsweise durch das Picken einer Taube auf die uns schon bekannte Schaltfläche, abgeschaltet werden, um dann nach einiger Zeit, beispielsweise 10 Sekunden, wieder automatisch eingeschaltet zu werden.

Entsprechend der aktuellen Erkenntnisse und Theorien wurden dabei wohl zwei unterschiedliche Auswirkungen dokumentiert. Bei einem Teil der Tiere kam es scheinbar dazu, dass die Auftrittswahrscheinlichkeit des Verhaltens „Picken auf die Schaltfläche“ der Tiere anstieg, um den Strom abzuschalten. Sicherlich konnte auch dokumentiert werden, dass diese Tiere kurz vor dem automatischen Einschalten des Stroms vermehrt auf die Scheibe pickten und so verhinderten, dass er wieder zu fließen begann.

Ein anderer Teil der Tiere fand aber keinen Zusammenhang zwischen dem Picken auf die Schaltfläche und dem Abstellen des Stromes. Diese Tiere zeigten unterschiedliche Arten teilnahmslosen, inaktiven Verhaltens. Bei dieser Gruppe hatte also die negative Konditionierung nicht funktioniert.

Der Anteil derer, die erfolgreich negativ konditioniert werden konnte, lag wahrscheinlich in der Gruppe, die vorher schon einmal positiv auf das Picken der Schaltfläche konditioniert wurde, höher, als bei denen, die noch keine Erfahrung mit der Schaltfläche gemacht hatten.

Im dritten Schritt, bei dem die Konfiguration der Box wieder der stromfreien im ersten Schritt entsprach, sollte nun festgestellt werden, ob die Auftrittswahrscheinlichkeit des konfigurierten Verhaltens nun wieder sinkt und das Verhalten gelöscht wird. Es stellte sich heraus, dass die Effekte der Löschung bei den erfolgreich Konditionierten viel geringer waren, als es bei der positiven Verstärkung der Fall war.

Wie liefen die Versuche Skinners zu negativer Bestrafung ab?

| Auf das Verhalten folgender Reiz... | ...ist unangenehm/aversiv (Strom im Boden der Skinner-Box) | ...ist angenehm/appetitiv (Futtergabe) |

| ...endet oder beginnt erst gar nicht | negative Verstärkung | negative Bestrafung |

| ...beginnt | 3 | positve Verstärkung |

Wie ein Experiment Skinners zur negativen Bestrafung aufgebaut war, war weder recherchierbar, noch fühle ich mich befähigt, es aus den Theorien und überlieferten Experimenten Skinners abzuleiten. Mir möchte kein Weg einfallen, wie die Skinner Box aufgebaut sein muss, dass sie automatisch einen angenehmen Reiz (beispielsweise Futter) entfernt, wenn ein bestimmtes Verhalten gezeigt wird: So lange einer auf 80 % abgemagerten Taube Futter dargereicht wird, wird sie fressen und kein anderes Verhalten zeigen. Das Fressen wiederum kann aber kaum durch Entfernen des Futters (angenehmer Reiz) bestraft werden.

Wäre die Taube später satt und würde deshalb auch anderes Verhalten zeigen, das bestraft werden könnte, stellt sich die Frage, ob das Futter dann noch einen angenehmen Reiz darstellen würde, dessen Entfernung tatsächlich das Verhalten der Taube beeinflussen würde, da sie sich ja in ihrem satten Zustand weniger für das Futter interessiert.

Außerhalb des Tierexperiments, beispielsweise im Straßenverkehr, wird aber schnell klar, was gemeint ist: Der Führerschein und damit die Erlaubnis, Auto zu fahren, stellt den angenehmen Reiz dar. Betrunkenes oder zu schnelles Fahren ist das Verhalten, dass es zu minimieren gilt. Die negative Strafe wäre dann der Entzug des Führerscheins.

Allerdings beobachten wir, dass häufig trotzdem die Verkehrsregeln gebrochen werden und erst beim Anblick einer Geschwindigkeitskontrolle stark gebremst wird. Warum das so ist, hat Skinner wieder belegbar ergründet, wie wir sehen werde, wenn wir uns im Anschluss an das Kontingenzschema mit den Hinweisreizen beschäftigen.

Wie liefen die Versuche Skinners zu positiver Bestrafung ab?

| Auf das Verhalten folgender Reiz... | ...ist unangenehm/aversiv (Strom im Boden der Skinner-Box) | ...ist angenehm/appetitiv (Futtergabe) |

| ...endet oder beginnt erst gar nicht | negative Verstärkung | negative Bestrafung |

| ...beginnt | positive Bestrafung | positve Verstärkung |

Versuche zur positiven Bestrafung sind überliefert.

Um die Auswirkung eines unangenehmen Reizes auf das ihm vorangehende Verhalten zu erforschen, wurde die Box nun so verdrahtet, dass das Picken auf die Schaltfläche einen leichten, aber sicher als aversiv empfundenen Stromstoß im Boden der Box auslöste.

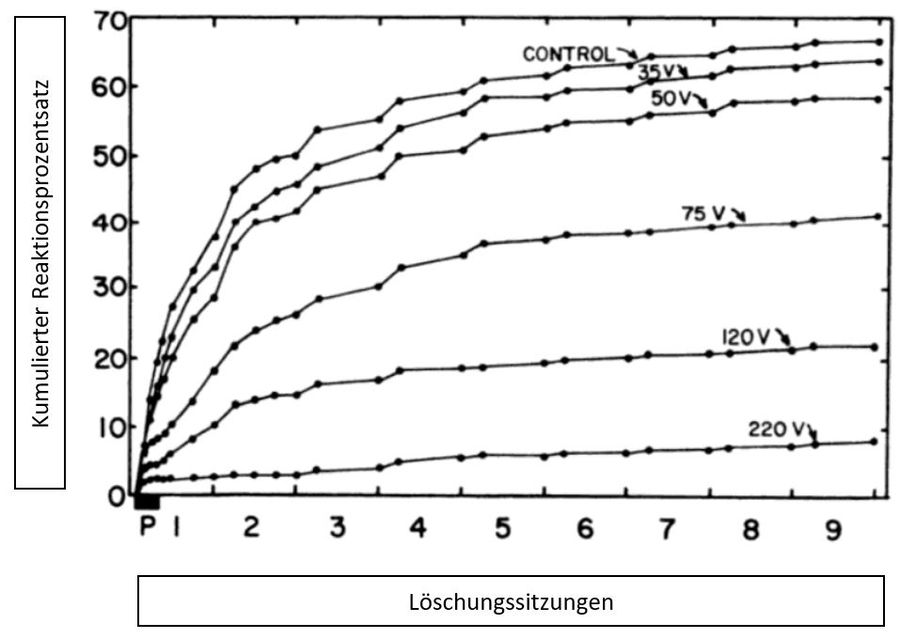

Nun wurden einige Tauben über positive Konditionierung trainiert, auf die Schaltfläche zu picken und dann in zwei Gruppen aufgeteilt. Einer Gruppe wurde in den folgenden Sitzungen das Picken auf die Schaltfläche nicht verstärkt, es erfolgte also eine Löschung. Die andere Gruppe wurde für das Picken auf den Schalter bestraft, indem ihnen ein leichter Stromstoß als aversiver Reiz über den Fußboden verabreicht wurde.

Gemessen und miteinander vergleichen wurde für beide Gruppen die Reaktionsrate im Zeitverlauf. Im Ergebnis verringerte sich die Reaktionsrate der bestraften Tauben im Vergleich zur lediglich in der Löschungsphase befindlichen Tauben zunächst signifikant.

In einer letzten Experimentphase wurde nun beide Gruppen wie in einer Löschung behandelt: Das Picken wurde weder verstärkt, noch bestraft.

Nun wurde erkennbar, dass in der Gruppe, die vorher Bestrafung erfuhr, die Reaktionsrate nun, da keine Bestrafung mehr erfolgte, zunächst zunahm und sich dann so weiterentwickelte, also abnahm, wie es unter der Bedingung der Löschung zu erwarten war.

Im Ergebnis war bei beiden Gruppen die Reaktionsrate nach einiger Zeit auf demselben Niveau angekommen.

Welche Schlüsse zog Skinner aus diesen Versuchen: Das Kontingenzschema

Ähnlich, wie schon bei der positiven Konditionierung, definierte Skinner auch zu den drei weiteren Varianten die Begrifflichkeiten.

Für die negative Konditionierung sieht das folgender Maßen aus: Der aversive (unangenehme) Reiz, der von dem im Boden fließenden Strom ausgeht, wurde von Skinner „negativer Verstärker“ genannt. Hierbei ist wichtig, dass ein aversiver Reiz immer nur dann ein Verstärker ist, wenn das seinem Wegfall vorangegangene Verhalten so beeinflusst wird, dass es künftig häufiger gezeigt wird, also die Auftrittswahrscheinlichkeit des Verhaltens steigt. Negativ wird der Reiz dadurch, dass er nach dem Verhalten entfällt oder endet. Durch negative Konditionierung kann Vermeidungsverhalten aufgebaut werden. Es führt dazu, dass der negative Reiz durch frühzeitige, die Situation vermeidende Reaktionen wie Flucht gar nicht erst auftritt. Dies führt wiederum dazu, dass der negative Reiz erst gar nicht entsteht und wahrgenommen werden kann. Da aber die Situation gemieden wird, kann auch nicht wahrgenommen werden, ob der negative Reiz unabhängig vom Verhalten gar nicht mehr auftritt. Diese Wirkungskette begründet die hohe Widerstandsfähigkeit des über negative Konditionierung aufgebauten Verhaltens gegenüber der Löschung.

Hiervon zu unterscheiden ist die negative Bestrafung, die auf die Verringerung einer unerwünschten Verhaltensweise zielt: Wird das unerwünschte Verhalten gezeigt, wird ein grundsätzlich vorhandener, als Verstärker dienender appetitiver/angenehmer Reiz entfernt (negiert).

Die positive Strafe zeichnet sich dadurch aus, dass der unangenehme Reiz als Folge unerwünschten Verhaltens auftritt. Gegenüber der Löschung scheint sie kurzfristig schneller zum Erfolg zu führen. Allerdings holt die Löschung im Zeitverlauf den Vorsprung der Strafe auf, was aber nur dann möglich ist, wenn die Verhaltensverstärker unter kontrollierbar sind und nicht mehr in Folge des zu löschenden Verhaltens verfügbar werden.

So wird klar, dass die Begriffe „positiv“ und „negativ“ keine Wertung enthalten, sondern lediglich ausdrücken, ob ein Reiz in Folge eines Verhaltens gegeben wird (positiv) oder entzogen bzw. negiert (negativ) wird.

Skinner fasste die drei zu einem Kontingenzschema zusammen, aus dem hervorgeht, welche Reize mit welcher Verhaltensänderung einhergehen. Aus dem Schema geht nicht nur die enge Verbundenheit von Reizen und Verhalten hervor, sondern auch, dass er die Begriffe „Verstärker“ und „Bestrafung“ nur auf Grund ihrer beobachteten Auswirkung auf das operante Verhalten definiert sind. Daher lässt sich vor Beginn des Experiments oder der Ausbildung bestenfalls abschätzen, nicht aber mit Sicherheit wissen, wie ein Reiz wirken wird.

| Auf das Verhalten folgender Reiz | Auftrittswahrscheinlichkeit des Verhaltens steigt | Auftrittswahrscheinlichkeit des Verhaltens sinkt |

| beginnt | positive Verstärkung | positive Bestrafung |

| endet oder beginnt erst gar nicht | negative Verstärkung | negative Bestrafung |

Welche Fragen stellten sich aus Skinners Versuchen zum Kontingenzschema?

In den Experimenten hatte sich gezeigt, dass Verhalten nur über positive und negative Verstärkung aufgebaut werden kann, während positive und negative Strafen nur dazu dienen können, ein Verhalten abzubauen. Sie dienen aber insbesondere nicht dazu, ein geeignetes Alternativverhalten aufzubauen und lassen den Bestraften insofern etwas ratlos zurück. Skinner schloss außerdem aus seinen Ergebnissen zur positiven Bestrafung, dass Bestrafung ineffektiv sei. Dem schlossen sich nicht alle folgenden Wissenschaftler an, sodass wir uns mit der Forschung zu Bestrafungen in Block 8 diese Artikels noch intensiv befassen werden.

Bewertet man nun die positive und negative Verstärkung, stellt man fest, dass das aufgebaute Verhalten bei der positiven Konditionierung sehr schnell wieder gelöscht wird, wenn die Verstärkung ausbleibt. Wird nur der Aspekt der Dauerhaftigkeit eines konditionierten Verhaltens betrachtet, könnte man schnell auf die Idee kommen, dass die negative Verstärkung das Mittel der Wahl ist. Jedoch würde dann übersehen, dass ein erheblicher Teil der Versuchstiere bei der negativen Konditionierung das erforderliche Verhalten nicht gelernt hat, sondern nur uneffektives Verhalten gezeigt hat und schließlich in einen teilnahmslosen, apathischen Zustand verfallen ist, der sogenannten und unten in Block 8 behandelten gelernten Hilflosigkeit.

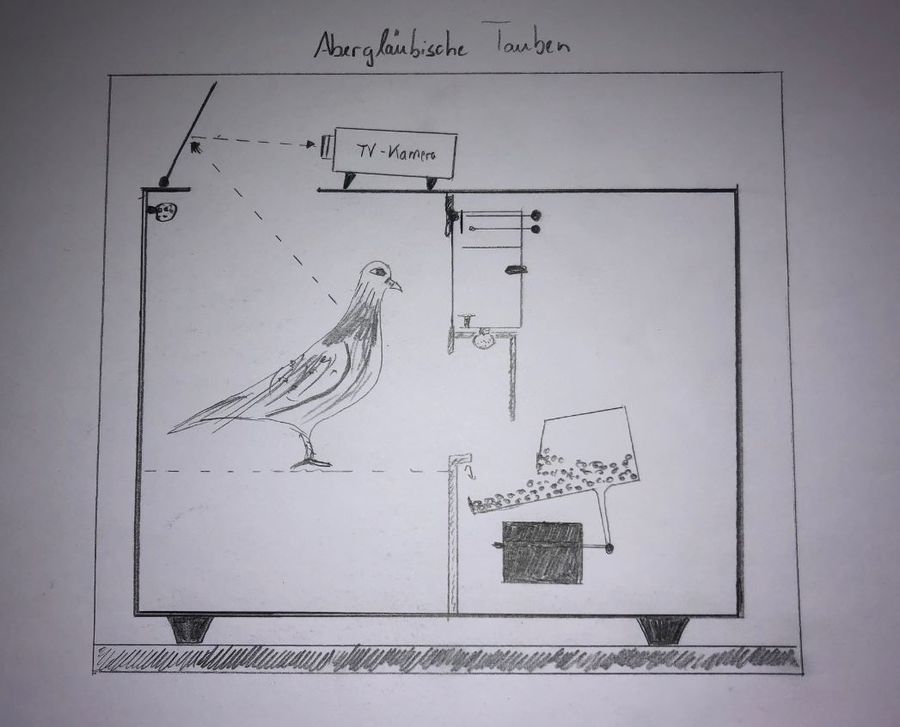

Skinner war außerdem der Meinung, dass außerhalb des Labors Verhalten nicht in derart gleichmäßiger und vorhersehbarer Art und Weise verstärkt wird: Beispielsweise führt nicht jede Jagd eines Beutegreifers auch zu Beute oder jedes Spiel an einem Automaten zu einem Gewinn. Dennoch kann klar beobachtet werden, dass Raubtiere immer wieder jagen und einige Menschen immer wieder ihr Glück am Spieltisch versuchen.

Diese Tatsache weckte Skinners Interesse an Versuchen zu Verstärkerplänen. Außerdem stellte sich die Frage, ob solche Verstärkerpläne Auswirkungen auf die Konditionierungsgeschwindigkeit und die Löschungsresistenz bei positiver Verstärkung haben. Diesem Themenkomplex ist mit dem nächsten Block dieses Textes ebenfalls ein großer Abschnitt gewidmet.

Ebenfalls war ihm nun zwar klar, dass die Auswirkungen von Verhalten dasselbe beeinflussen. Der bisherige Versuchsaufbau lässt aber außer Acht, ob und wie Verhaltens situationsabhängig gezeigt werden kann. Die Reize, die eine Situation ausmachen, nannte Skinner „diskriminative“ Reize.

Die Forschung Skinners zu diskriminativen Reizen – mehr als Kommandos

Widmen wir uns aber zunächst Skinners Frage nach situationsabhängigem Verhalten.

Skinners Forschungsziel – Wie adaptieren Organismen ihr Verhalten in unterschiedlichen Situationen?

Als Skinner das Kontingenzschema unter Ausschluss aller anderen Umwelteinflüsse in seinen Skinner Boxen erforschte, war ihm klar, dass außerhalb dieser sterilen Laborbedingungen weitere als Reize wahrgenommene Umwelteinflüsse auf das Verhalten eines Lebewesens wirkt. So ist ihm klar, dass beispielsweise trotz Strafbewehrung gegen Verbote verstoßen wird. Auch konnte er schon damals beobachten, dass ein Hund vor allen Dingen nach einem Kommando Sitz machte und nicht immer und ewig in der entsprechenden Haltung verharrt. Die hier genannten Reize definieren in ihrer Summe die Situation, in der ein bestimmtes Verhalten gezeigt oder vermieden wird.

Der Versuchsaufbau: Erweiterung der Skinner Box um einen diskriminativen Reiz

Nachdem die Tauben im oben beschriebenen Experiment zur positiven Verstärkung gelernt hatten, mittels Picken auf einen Knopf den Futterspender auszulösen, wurde die Skinner Box mit einer Lampe und/oder einem Lautsprecher ausgestattet. Nun wurde die gesamte Technik so verdrahtet, dass der Futterspender nur dann ausgelöst werden konnte, wenn entweder das Licht brannte oder der Ton zu vernehmen war. Allerdings wurde darauf geachtet, dass der Effekt der Löschung nicht eintreten konnte, von dem Skinner schon wusste, in welchem zeitlichen Fenster dieser einsetzen würde. Entsprechend wurde darauf geachtet, dass Licht oder Ton und damit die Futtergabe früh genug gegeben war und die Frequenz zwischen an und aus hoch genug war, damit eben keine Löschung erfolgte.

Um die Versuche zur positiven Bestrafung um einen diskriminativen Reiz zu erweitern, wurde der aus der positiven Verstärkung bekannte Versuchsaufbau, in dem das Picken auf einen Schalter eine Verstärkung durch Futter brachte, so abgeändert, dass der einer zu bestrafenden Verhaltensweise folgende unangenehme Reiz nicht mehr automatisch, sondern von einem Menschen mittels Knopfdruck verabreicht wurde. Konkret stand also dieser Labormitarbeiter mit einer Fernbedienung vor der in beide Richtungen durchsichtigen Skinner-Box. Somit konnte er von dem Versuchstier gesehen und beobachtet werden, wenn der mittels Knopfdruck in den Boden der Skinner Box einen kurzen Stromstoß sandte.

Versuche zu diskriminativen Reizen – die Einführung von Hinweisreizen in der positiven Verstärkung

Nun konnten die Forscher messen, dass die Tauben zu Beginn dieses Experiments das erlernte Verhalten zeigten: Sie pickten immer weiter auf den Auslöser.

Bald schon ergaben die Messungen, dass die Tauben nur noch sehr selten den Auslöser betätigten, wenn kein zusätzliches Signal gegeben wurde, aber sehr viel häufiger, wenn es gegeben wurde.

Damit hatten die Tiere gelernt, das Licht oder den Ton als diskiriminativen Reiz oder als Hinweisreiz zu deuten, der anzeigt, wann ein bestimmtes Verhalten zu einer angenehmen Konsequenz führt und daher lohnenswert ist und wann das Verhalten nicht lohnenswert ist, da eben kein positiver Verstärker folgt.

Versuche zu diskriminativen Reizen – die Wirkung von Hinweisreizen bei Strafandrohungen

Es wurden nun Versuchstiere, die über die positive Verstärkung bereits so konditioniert wurde, dass sie auf den Schalter picken, um Futter zu erhalten, in die Skinner-Box gesetzt. Dort verhielten sie sich entsprechend der Konditionierung und pickten häufig auf die Schaltfläche und erhielten weiterhin Futter.

Nach einiger Zeit trat jedoch der Versuchsleiter an die Box und nahm die Fernbedienung in die Hand, um auf jedes Picken hin einen kurzen Stromstoß in den Boden der Skinner Box zu leiten, bevor das Tier an das immer noch ausgelöste Futter gelangen konnte. Nach einigen Durchläufen aus Picken und Stromstoß legte der Laborant den Auslöser aus der Hand und entfernte sich von der Box.

Zu beobachten war nun, dass die Versuchstiere nach einigen wenigen Durchgängen die Anwesenheit des Laboranten als Hinweisreiz wahrnahmen: Ist er anwesend, folgt dem Verhalten ein aversiver und damit strafender Reiz und das Picken auf die Schaltfläche wurde eingestellt. War er nicht zu sehen, wurde intensiv gepickt, da dann dem Verhalten ein angenehmer Reiz folgte: nämlich das Erreichen und Fressen des Futters.

Welche Schlüsse und Fragen ergaben sich aus den Versuchen zu den Hinweisreizen?

Bezogen auf die positive Konditionierung ergibt sich der Schluss, dass der Hinweisreiz ein Verhalten auslösen kann, da der diskriminative Reiz darauf hinweist, dass dem entsprechenden Verhalten ein angenehmer Reiz folgen wird. Aus diesem Grund lohnt es sich für den Organismus, dieses Verhalten in Folge des Hinweisreizes zu zeigen. Da das von Skinner entwickelte Reaktion-Reiz-Modell nun um ein weiteres Element zu einem Reiz-Reaktion-Reiz-Modell erweitert wurde, spricht man nun von der Dreifachkontingenz aus Hinweisreiz, operanten Reaktion und Verstärkung/Verstärkungsreiz, wobei jedes Kettenglied für das folgende eine hohe Vorhersagekraft besitzt.

Bezogen auf die Versuche zur Bestrafung lassen sich aus der Beobachtung, dass das unter Strafe stehende Verhalten nur dann nicht mehr gezeigt wird, wenn der strafende Labormitarbeiter anwesend war, zwei Schlussfolgerungen ziehen. Einerseits, dass die Anwesenheit des Labormitarbeiters für die Tiere zum Hinweisreiz eines ihrem Verhalten folgenden aversiven Reizes, also der Strafe ist. Andererseits, dass eine Strafe nicht zu einer Verhaltenslöschung oder einer nachhaltigen Verhaltensänderung führt, sondern lediglich zu einer Verhaltensunterdrückung in Erwartung der Strafe. Wird auf Grund eines Hinweisreizes wie der Abwesenheit des Labormitarbeiters Straffreiheit erwartet, tritt das Verhalten wieder auf.

Die Forschung Skinners & seiner Nachfolger zu Verstärkerplänen

Der Hund soll nicht alles nur für Futter und Belohnung tun! Das hört man häufig und es stimmt nicht nur, sondern weniger Belohnen kann sogar ein Verhalten weiter festigen. Wie das geht, zeigt Skinners Forschung zu Verstärkerplänen.

Was sind Verstärkerpläne?

Wie für die operante Konditionierung insgesamt, so legte Skinner auch den Grundstein für die Erforschung von Verstärkerplänen. Hierbei handelt es sich um Regeln, die festlegen, wann ein gewünschtes oder zu konditionierendes Verhalten verstärkt wird. Wir werden uns hier mit den vier „einfachen“ Verstärkerplänen beschäftigen, die von Skinner zunächst miteinander verglichen wurden. Zu diesen vier Verstärkungsplänen gibt es schon viel zu sagen und vor allem begründen die Beobachtungen einige Fragen. Diese zu beantworten war für die Wissenschaft nicht einfach, weshalb die Antworten zu liefern entsprechend lange dauerte und Teil der Arbeit anderer Forscher war.

Skinners Forschungsziel – Die Auswirkungen unregelmäßiger Verstärkungen

Skinner fragte sich, wie wir im Abschnitt zum Kontingenzschema gesehen haben, ob die Tatsache, dass im Leben außerhalb des Labors Verhalten nicht jedes Mal, sondern eher in unregelmäßiger Art und Weise verstärkt wird, im Labor nachgestellt werden kann und welche Auswirkungen es haben würde, wenn die Vorhersagekraft, die ein Verhalten auf die Verstärkung hat, herabgesetzt wird.

Wir haben gesehen, dass zwar ein Verhalten schnell über die positive Verstärkung konditioniert werden kann, aber auch sehr schnell nicht mehr gezeigt wird und somit gelöscht wird, wenn keine Verstärkung mehr erfolgt. Als Alternative, ein Verhalten so zu festigen, dass es auch ohne weitere Verstärkung gezeigt wird, steht zu diesem Zeitpunkt nur die negative Verstärkung zur Verfügung. Diese birgt aber offenbar das Problem, dass sie nicht zu 100 Prozent erfolgreich verläuft, sondern ein Teil der Tiere in Apathie verfallen, statt das gewünschte Verhalten zu zeigen.

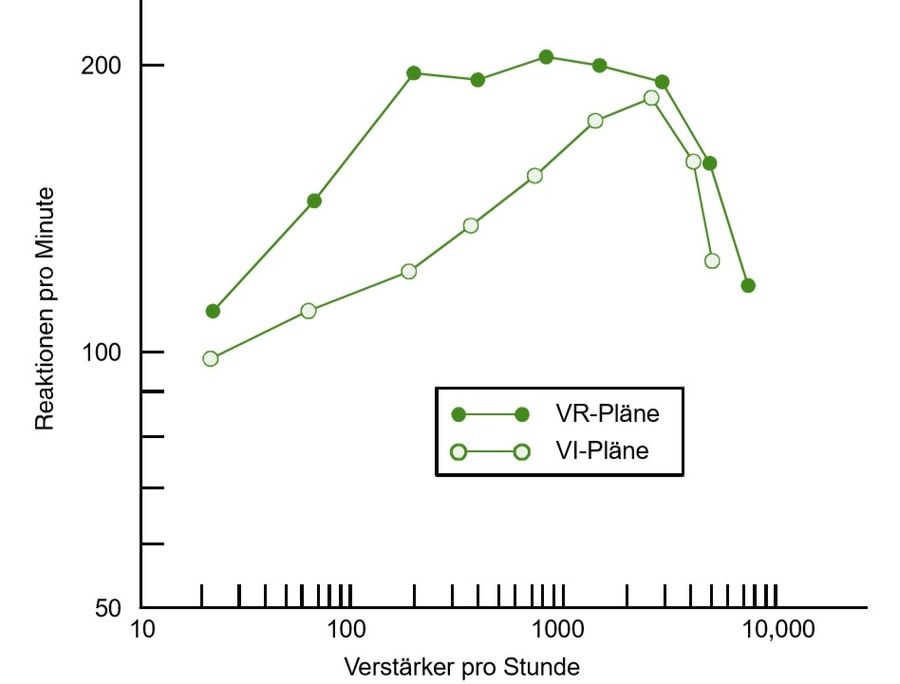

Skinners Frage war nun, ob und welche Auswirkung auf die Aquisitionsrate, die die Konditionierungsgeschwindigkeit beschreibt, und Extinktionsrate, die die Widerstandsfähigkeit gegen Löschung beschreibt, es hat, wenn Verstärkung bei der positiven Konditionierung nicht jedes Mal erfolgt, wenn das zu konditionierende Verhalten gezeigt wird. Die unterschiedlichen Regeln, nach denen die Verstärker gegeben werden können, nennt man Verstärker- oder Verstärkungspläne.

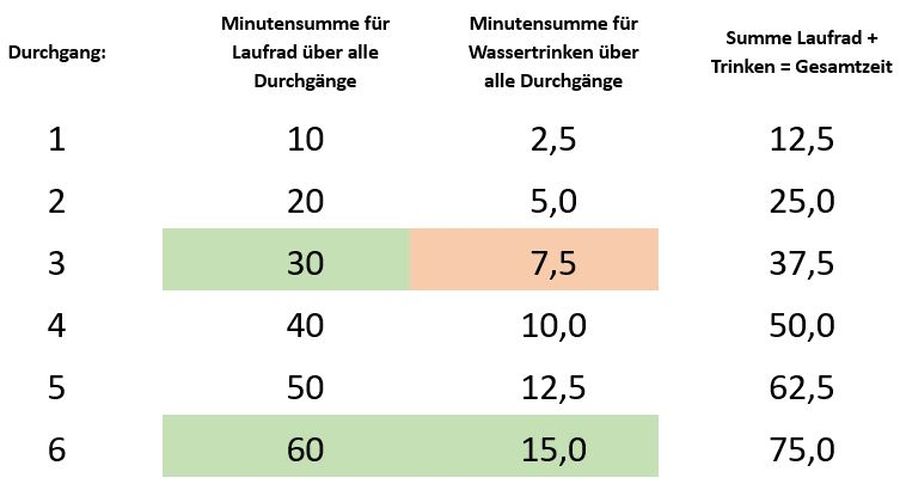

Der Versuchsaufbau: Adaptionen der Skinner Box für verschiedene Verstärkerpläne

Skinner war sich bewusst, dass es im realen Leben Verhalten gibt, das nicht jedes Mal zu einer Verstärkung führt. Außerdem war ihm klar, dass es zwei Größen gibt, die eine Auswirkung auf die Verstärkung haben: Die Anzahl der Wiederholungen eines Verhaltens einerseits und der Zeitpunkt, an dem das Verhalten gezeigt wird, andererseits.

Nimmt man an, dass ein Fuchs oder ein Hund 10 Versuche braucht, um einen Hasen zu fangen, wäre das ein auf der Anzahl der Wiederholungen des Verhaltens „hinter dem Hasen herlaufen“ basierender Verstärkungsplan, den Skinner Ratio-Plan, also Quotenplan, nannte. Sicherlich wäre es nicht so, dass der Jagderfolg immer den exakt jeden 10. Hasen treffen würde. Wäre es so, spräche Skinner von einem fixed Ratio Plan und wir in Deutschland von einem festen Quotenplan. Realistischer beschrieben wäre unser Beispiel, wenn mal zwei Jagden hintereinander erfolgreich und dann wieder 20 oder 30 Anläufe hintereinander erfolglos blieben, im Durchschnitt aber 1 von 10 Versuchen Erfolg brächten. In dem Fall wäre in den USA von einem variable Ratio Plan und bei uns von einem variablen Quotenplan die Rede.

Nimmt man an, dass ein Fuchsliebhaber im Wald eine Fütterung für den Fuchs einrichtet und jeden Tag um 12:00 Uhr dort etwas Futter für das Tier bereitstellt. Das Verhalten „die Futterstelle aufsuchen“ kann zwar unendlich oft am Tag gezeigt werden. Verstärkt wird es aber nur einmal in 24 Stunden. Somit spielt die Anzahl der Verhaltenswiederholungen keine, das richtige Timing aber eine große Rolle. In dem Fall sprechen wir über einen Intervallplan. Da das Intervall exakt feststeht, nämlich alle 24 Stunden, wird hier von einem fixed Interval Plan oder einem festen Intervallplan gesprochen. Würde der Fuchsliebhaber nicht immer pünktlich, aber auf jeden Fall einmal innerhalb von 24 Stunden die Fütterung bestücken, läge ein variable Interval Plan oder variabler Intervallplan vor.

Skinner versuchte nun, wie im Folgenden beschrieben, seine in den Versuchen zur positiven Verstärkung genutzten Skinner Boxen so umzurüsten, dass sie jeweils einen der vier beschriebenen Verstärkungspläne nachstellen und die Auswirkungen dokumentieren konnten.

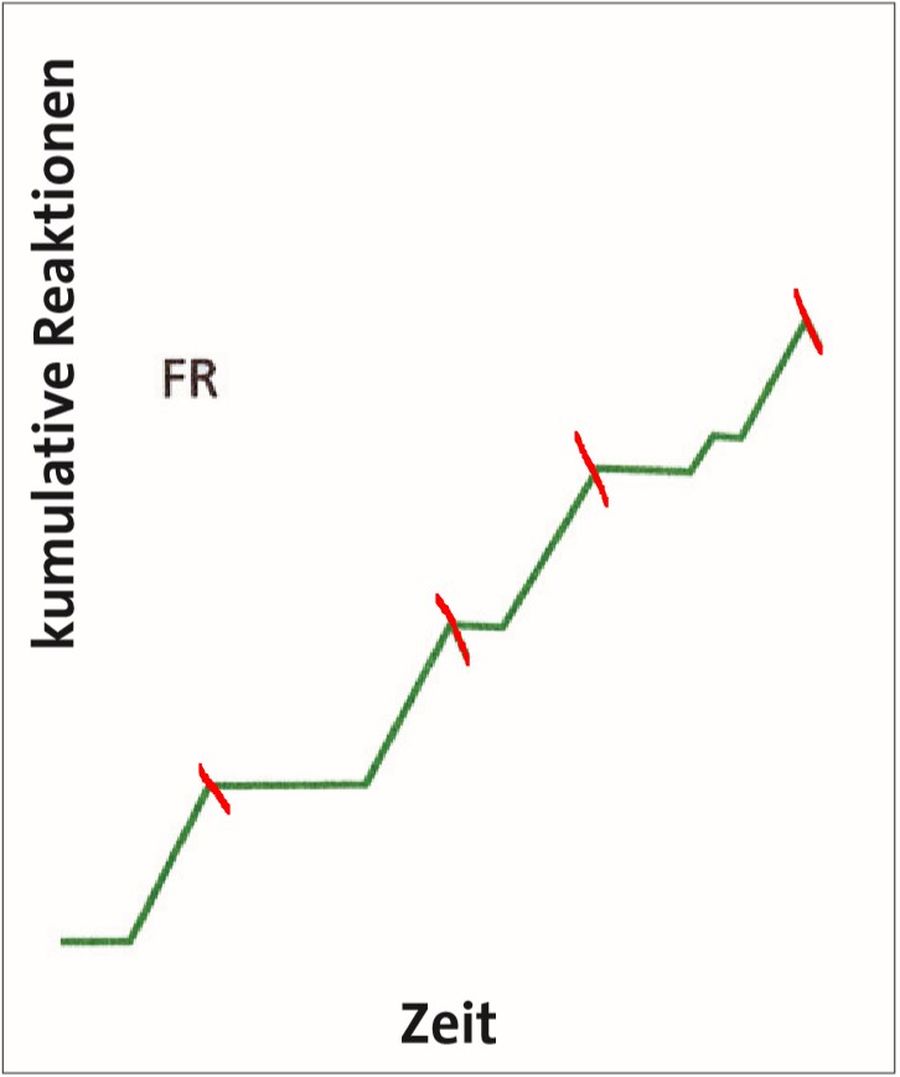

Adaption der Skinner Box für Fixed Ratio bzw. feste Quotenpläne

In einer Variante sollten Ratio- bzw. Quotenpläne erforscht werden, es ging also um die Anzahl der Wiederholungen eines Verhaltens. Ausgehend von der Immerverstärkung, bei der nach jeder gewünschten Reaktion einer Verstärkung erfolgt, wurde der schon vorhandene Zählmechanismus so verdrahtet, dass der Versuchsleiter die für eine Verstärkung notwendige Anzahl an Verhaltenswiederholungen einstellen konnte. Hierbei sprach Skinner von einem „fixed ratio plan“, der in Deutsch fixer Quotenplan genannt wird. Insofern kann man die Immerverstärkung als einen fixen Quotenplan mit der Ziffer 1 (FR-1-Plan) betrachten. Allerdings wird im Allgemeinen erst dann von einem fixen Quotenplan gesprochen, wenn die Ziffer und damit die Quote höher als 1 ist, beispielsweise FR-2-Plan, bei dem jede 2. zu konditionierende Reaktion verstärkt wird.

Adaption der Skinner Box für Variable Ratio bzw. variable Quotenpläne

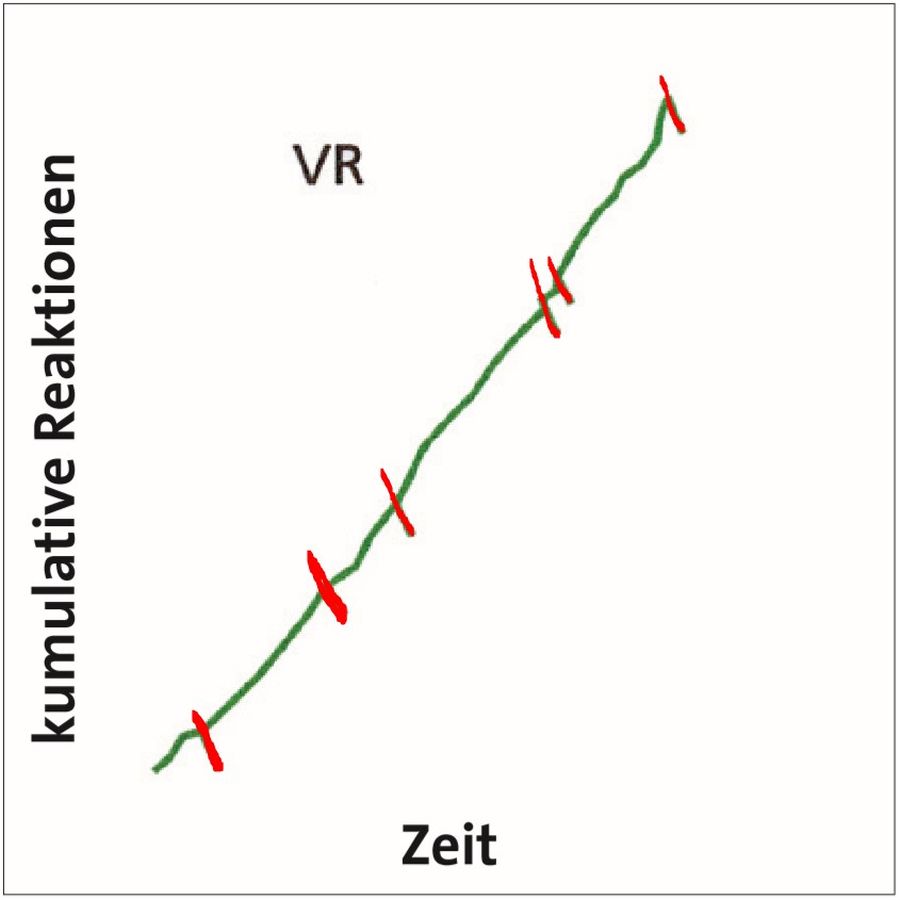

Die Box konnte aber auch so eingestellt werden, dass der Zählmechanismus eine vorher festgelegte Anzahl von Verstärkungen auf eine ebenfalls vorher festgelegte Gesamtmenge Wiederholungen unregelmäßig verteilt. Wichtig ist, dass ein Durchschnittswert von Wiederholungen für eine Verstärkung definiert war. Wird also nur eine Durchschnittsquote definiert, sprach Skinner von einem „variable ratio plan“ und die deutschen Wissenschaftler von einem variablen Quotenplan. Einen Verstärkerplan nach dem Schema der Immerverstärkung könnten man als einen VR-1-Plan bezeichnen. Üblich sind allerdings Pläne, bei denen die Quote höher ist, also ab einem VR-2-Plan. Ein VR-2-Plan sähe also vor, dass auf 10 korrekte Verhaltensweisen 5 Verstärkungen, auf 100 Verhaltensweisen 50 Verstärkungen kämen. Dabei wäre es dann möglich, dass auf die ersten 5 Wiederholungen keine Verstärkung erfolgt, dafür aber die letzten 5 alle verstärkt würden.

Adaption der Skinner Box für feste und variable Intervallpläne

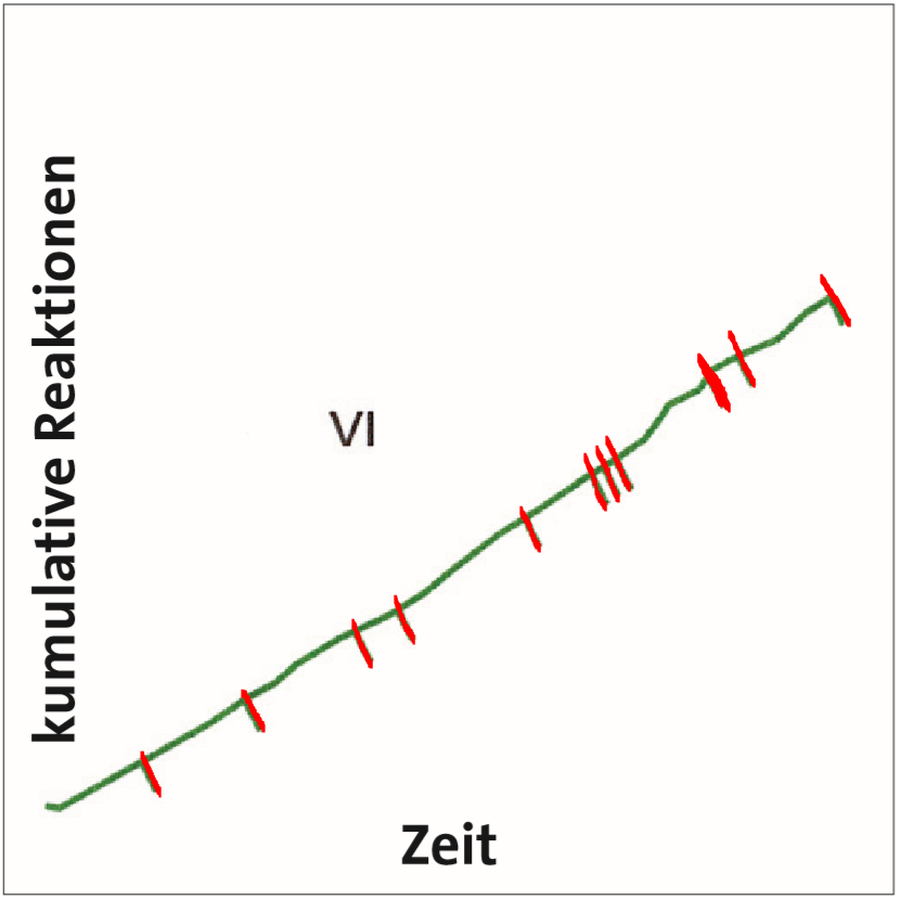

In der zweiten Variante wurden Intervallpläne erforscht. Es wurde eine Art Wecker eingebaut, damit die Verstärkung zeitabhängig gegeben werden konnte. Der Wecker konnte so eingestellt werden, dass er, statt zu klingeln, einen Stromkreis schloss. Dadurch löste das nächste gewünschte Verhalten, beispielsweise das Picken auf die Schaltfläche, eine Verstärkung aus. Der Wecker konnte nun für eine Versuchsgruppe so eingestellt werden, dass er nach einer festen Zeitspanne, z. B. alle 5 Minuten, das Verstärkungssystem einschaltete. In dem Fall spricht man von einem fixen Intervallplan, Skinner von einem „fixed interval plan“. Für die andere Versuchsgruppe konnte er aber auch so eingestellt werden, dass er in einer festgelegten Gesamtzeitspanne in unregelmäßigen Zeitabständen das Verstärkungssystem einschaltete, dass im Durchschnitt ein vorher festgelegter Zeitintervall eingehalten wurde. So könnte eine Regel konkret lauten, dass das Verstärkersystem in unregelmäßigen Abständen 12 Mal pro Stunde frei geschaltet werden soll. 60 Minuten geteilt durch 12 Freischaltungen ergibt im Durchschnitt wieder eine Freischaltung alle 5 Minuten. Hierbei handelt es sich um eine variablen Intervallplan.

Wie liefen die Versuche Skinners zu Verstärkungsplänen ab?

Für alle Experimente zu den verschiedenen Verstärkerplänen wurde ähnlich verfahren, wie schon in den ursprünglichen Versuchen zur positiven Verstärkung: Versuchstiere, die noch nie in der Skinner Box gesessen hatten, bekamen im Vorfeld der Experimente freien Zugang zu Futter und Wasser. Sie wurden täglich gewogen, um ihr Normalgewicht zu ermitteln. Dann wurde der Zugang zu Futter begrenzt, sodass sie nach einigen Tagen auf 80 % ihres Normalgewichts kamen. Damit sollte sichergestellt werden, dass die Verfügbarkeit von Futter als angenehm empfunden wird und die Gabe von Futter als Konsequenz eines Verhaltens verhaltensverstärkend wirkt.

In der Kontrollphase all dieser Experimente wurden nun die Tiere einzeln in eine Skinner Box gesetzt, ohne, dass das Picken auf die Schaltfläche eine Futtergabe auslöste. So wurde gemessen, wie häufig ein Tier vor der Konditionierung in einer bestimmten Zeitspanne auf die Schaltfläche pickt, es wurde also die Basisreaktionsrate des gewünschten Verhaltens und damit die Auftrittswahrscheinlichkeit des Pickens auf die Schaltfläche für jedes einzelne Tier gemessen.

Nun wurden die Tiere für Akquisitionsphase und die Löschungsphase in vier Gruppen aufgeteilt, damit für den festen Quotenplan, den variablen Quotenplan, den festen Intervallplan und den variablen Intervallplan jeweils ein Anzahl Probanden zur Verfügung stand.

Die Versuche zu Quotenplänen

Eine Gruppe von Probanden kam nun in eine Box, die nach einer festen Anzahl an Wiederholungen eine Verstärkung auslöste, die andere Gruppe in eine Box, die unregelmäßig nach festgelegten Durchschnittwerten verstärkte. Natürlich wurden viele Versuchsreihen unternommen, in denen die Anzahl der regelmäßig oder durchschnittlich bis zur Auslösung einer Verstärkung notwendigen Wiederholungen des Pickens auf die Schaltfläche variiert wurde.

Während der Akquisitionsphase, in der ein bestimmtes Verhalten erworben oder konditioniert wird und in der die Reaktionsrate folglich zunimmt, wurde sowohl für die fixe wie für die variable Quotenverstärkung beobachtet, dass die Akquisitionsrate, mit der die Geschwindigkeit des Verhaltenserwerbs ausgedrückt wird, umso niedriger ist, je höher die Quoten sind: Je öfter das gewünschte Verhalten vor der Gabe einer Verstärkung gezeigt werden muss, desto langsamer verläuft der Verhaltenserwerb.

Außerdem zeigte sich, dass von Tieren, die nach festen Quotenplänen trainiert wurden, nach jeder Verstärkung für einige Zeit eine Pause eingelegt wurde, in der sie das konditionierte Verhalten nicht zeigten und die abrupt endete. Hierfür wurde der Begriff der Nachverstärkerpause geprägt, die bei variablen Quotenplänen nicht beobachtet wurde, sodass die variablen Quotenplänen eine kontinuierlichere Reaktionsrate zeigten.

In der Löschungsphase, in der keine Verstärkung mehr erfolgt, wird die Extinktionsrate, also die Geschwindigkeit, mit der Reaktionsrate abnimmt gemessen. Hierbei wurde festgestellt, dass die Löschungsresistenz des konditionierten Verhaltens desto höher ausfällt, je höher die Quote, egal ob fix oder variabel, in der Akquisitionsphase gewählt war.

Die Versuche zu Intervallplänen

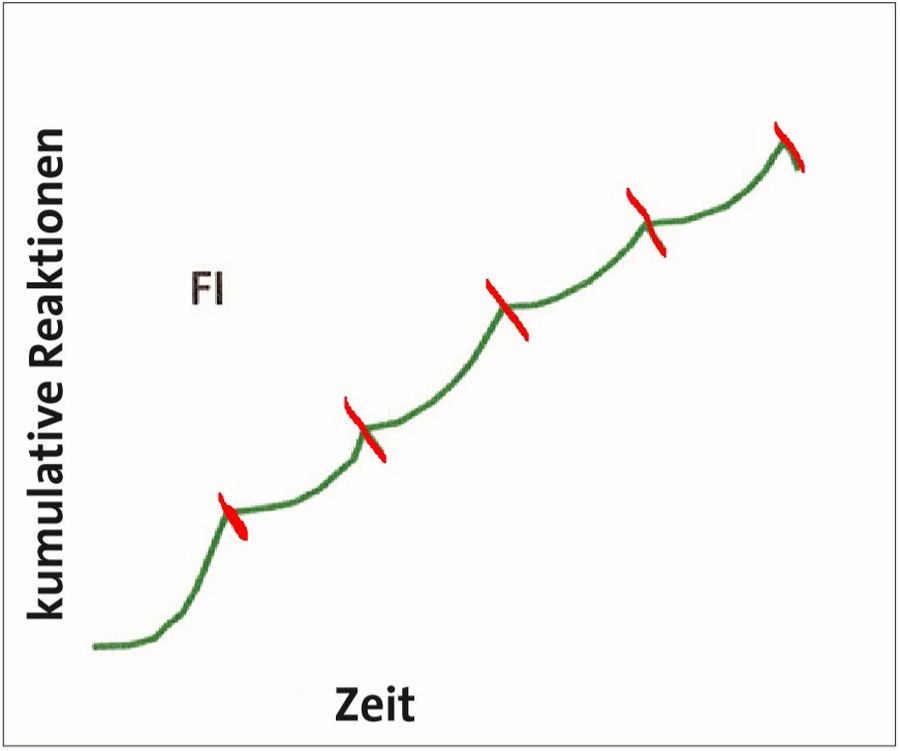

Ähnlich verfuhr er auch für die Versuche zur Intervallverstärkung, bei der zwischen den einzelnen Verstärkungen eine zeitliche Pause, ein Intervall liegt. In der Box für die eine Gruppe wurde nach einer immer gleichlangen Pause, also nach fixen Intervallen, dem sogenannten FI-Plan, verstärkt. In der anderen Box wurde nach dem VI-Plan verstärkt. Es wurde also nur die durchschnittliche Länge des Intervalls festgelegt, allerdings konnte jedes Intervall von diesem Durchschnittswert abweichen und viel kürzer oder auch länger dauern.

Auch bei den Intervallplänen zeigte sich, dass die Akquisitionsrate desto niedriger war, je länger die Intervalle gewählt waren.

Und, ähnlich wie bei den fixen Quotenplänen, zeigten sich auch bei den fixen Intervallplänen kein gleichmäßiger Verlauf der Reaktionskurve: Nachdem eine Verstärkung erfolgte, ging die Reaktionsrate stark herab und wuchs bis zum Zeitpunkt der nächsten Verstärkung stark an. Es wird als mit wenigen Reaktionen pro Minute wieder begonnen und kurz vor der nächsten Verstärkung weit mehr Reaktionen pro Minute gezeigt. Auf diese Weise entsteht im Diagramm der sogenannte FI-Bogen.

Bei den variablen Intervallplänen zeigten sich keine Nachverstärkerpausen, sondern wieder eine sehr kontinuierliche Reaktionsrate.

Zur Erinnerung: Bei der Reaktion kann es sich um das Picken auf den futterauslösenden Schalter durch die Tauben handeln.

Die Beobachtungen in der Löschungsphase der Experimente zu Intervallplänen ähnelten ebenfalls denen aus dem Versuchen zu Quotenplänen: Die Löschungsresistenz des konditionierten Verhaltens fällt desto höher aus, je länger das Intervall, egal ob fix oder variabel, in der Akquisitionsphase gewählt war.

Welche Schlüsse und Fragen ergaben sich aus den Versuchen?

Aus den Versuchen zu den grundlegenden und einfachen Verstärkerplänen ergeben sich drei Themen, die festgestellt wurden und die jeweils neue Fragen aufwarfen.

Wenn in einem Quotenplan die Anzahl der Reaktionen, also die Anzahl der Picks auf den Schalter, oder in einem Intervallplan die Länge der Intervalle zwischen den Verstärkungen heraufgesetzt wird, sinkt die Extinktionsrate. Durch intermittierende Verstärkungspläne wird also ein Verhalten durch geringere Mengen an Verstärkung löschungsresistenter konditioniert. Dies läuft aber dem Kontingenzprinzip zuwider. Dieses verlangt, wie wir schon gesehen haben, dass das Auftreten der Verstärkung durch die konditionierte Reaktion vorhergesagt werden können muss.

Dass die Akquisitionsrate ebenfalls runtergeht und der Verhaltenserwerb damit auch länger dauert, könnte hier einen ersten Hinweis zur Lösung dieser als Humphreys Paradox bekannten Frage liefern. Um hier mehr Licht ins Dunkel zu bringen, könnte es sich lohnen, schon im nächsten Abschnitt das Experiment von Tolman, das er mit Honzik im Jahr 1930 durchführte, zu beschreiben. Die im übernächsten Abschnitt aufgeführten Erklärungsansätze ändern an den Fakten und der Praxis wenig und sind der Vollständigkeit halber beschrieben.

Auch wurde festgestellt, dass feste Quoten zu Nachverstärkungspausen führen, in denen die gewünschte Reaktion nicht mehr gezeigt wird. Je höher die Quoten, desto länger wurde die Nachverstärkerpause. Die Wissenschaft war nun bestrebt, die Ursachen hierfür zu erforschen.

In den Versuchen zu fixen Intervallplänen konnte etwas ähnliches beobachtet werden: Hier lag die Aktivität nach einer Verstärkung auch niedrig und nahm exponentiell zu, bis sie kurz vor dem Zeitpunkt der nächsten Verstärkung einen Höchstwert erreichte.

Da auch festgestellt wurde, dass weder Nachverstärkungspausen noch die in den Intervallplänen beobachteten Pausen in den variablen varianten der Pläne auftraten und diese sich durch wünschenswert kontinuierliche Reaktionsraten auszeichnen, erscheint es sinnvoll, variable Quoten- und Intervallpläne versuchsmäßig zu vergleichen, um zu sehen, welche Pläne in der Praxis die gewünschten Ergebnisse erbringen und warum das so ist.

Edward Tolman und das Labyrinth für Ratten

Auch der 1886 in Massachusetts geborene Edward Tolman war als Psychologe ebenfalls Anhänger einer Art des Behaviorismus. Im Gegensatz zu Skinner, der nicht messbaren Vorgängen im Inneren eines Lebewesens keine Beachtung schenkte, war Tolman an diesen dennoch interessiert, was den Berkeley-Professor zu einem Vorreiter einer anderen Strömung, nämlich des Kognitivismus, werden ließ. Im Jahr 1930 führte er, unterstützt durch einen Kollegen namens Hoznik das für uns wesentliche Experiment an Ratten in einem Labyrinth durch, bei dem es darum ging, die Wirkung der Verstärkung auf den Verhaltenserwerb oder das Lernen zu ermitteln.

Der Versuchsaufbau und -ablauf

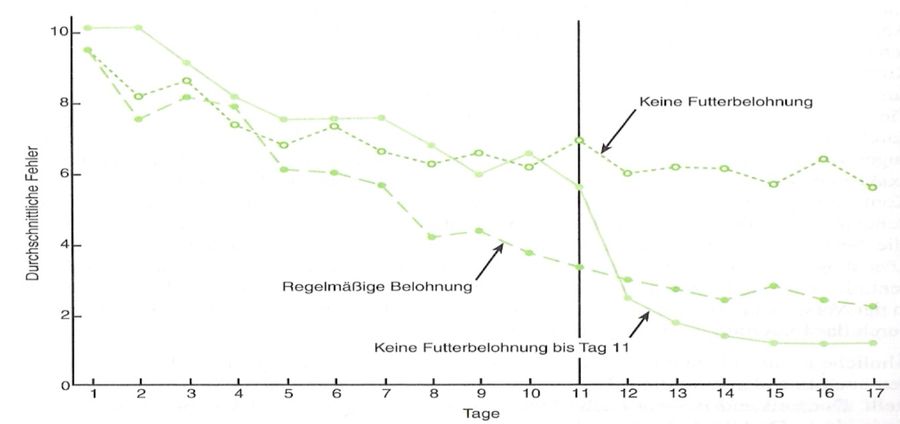

Es wurde ein Labyrinth gebaut, in dem es neben einem immer gleichen Startpunkt 14 Sackgassen gab, von denen eine als Zielstelle diente und an deren Ende eine Futterschale gestellt wurde.

Nun wurde an 17 aufeinanderfolgenden Tagen Laborratten in das Labyrinth gesetzt und gemessen, wie viele Fehler sie pro Durchgang machten, indem sie in eine falsche Sackgasse abbogen. Sie wurden erst aus dem Labyrinth genommen, wenn sie am Ziel angekommen waren.

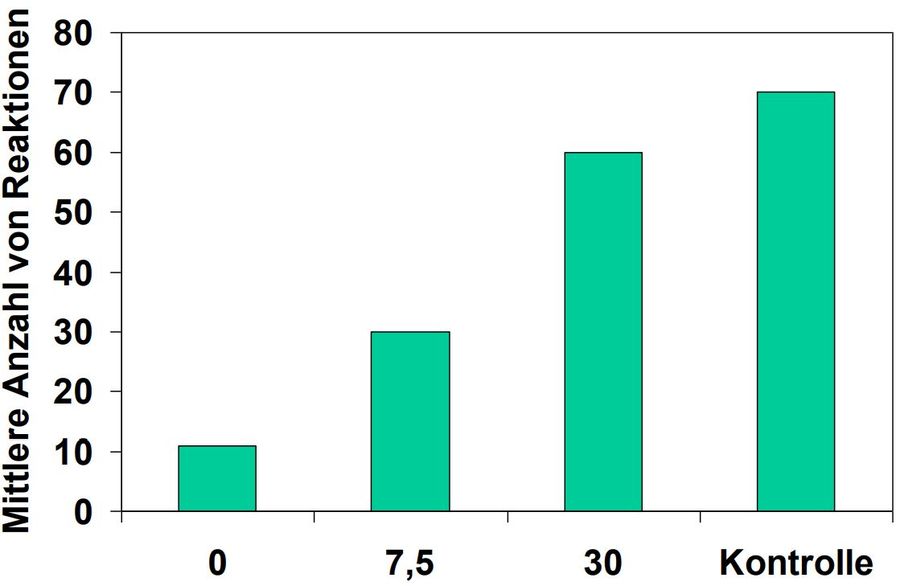

Um die Wirkung der Verstärker zu ermitteln, wurden die Ratten in drei Gruppen aufgeteilt. Gruppe 1 bekam an jedem der 17 Tage Futter in die Schale, während für Gruppe 2 an keinem der Tage die Schale gefüllt war. Die dritte Gruppe fand erst ab dem 11. Tag Futter in der Schale.

Die Ergebnisse des Versuchs

Es zeigte sich für die jeden Tag mit Futter verstärkte Gruppe 1 ein typisches Bild: Die Fehlerquote sank kontinuierlich von knapp 10 Fehlern auf knapp über 2. Ebenso erwartbar war das Ergebnis für die nie verstärkte Gruppe 2, die ihre Fehleranzahl nur minimal von 10 auf ca. 6,5 senken konnte.

Beachtenswert sind aber die Messungen für die Gruppe 3, die ab dem 11. Tag Futter am Zielpunkt vorfand und bis zu diesem Zeitpunkt, wie Gruppe 2, kaum ihre Fehlerquote senkte. Allerdings kam es zu einem abrupten Leistungsanstieg am 12. Tag: Wurden im 11. Durchgang noch durchschnittlich 6 Fehler gemacht, waren es im 12. nur mehr knapp über 2. Ab diesem Durchgang machte diese Gruppe weniger Fehler als die immer verstärkte Gruppe 1.

Die Schlüsse aus dem Versuch: Der Unterschied zw. Lernen und Performance

Tolman und Hoznik sahen also, dass die Ratten, die erst ab einem späteren Zeitpunkt eine Verstärkung erhielten, von einem Durchlauf zum anderen einen Leistungssprung in dem als „orientiere Dich in einem Labyrinth“ zu bezeichnenden Verhalten hinlegten.

Daraus schlossen sie, dass es einen Unterschied zwischen dem Erlernen eines Verhaltens und dem Zeigen dieses Verhaltens geben muss: Ein solcher Leistungssprung wäre nicht möglich gewesen, wenn die betreffenden Ratten nicht in den ersten 11 verstärkungsfreien Durchläufen schon gelernt hätten, sich in dem Labyrinth zu orientieren und somit Kompetenz aufgebaut hätten. Diesen Lernvorgang nannten sie latentes Lernen.

Aber erst die Verstärkung durch Futter ließ die Ratten das Verhalten zeigen oder performen. Insofern haben Verstärker rein motivierende Wirkung, ein Verhalten zu zeigen. Natürlich stellt das Lernen selbst ein Verhalten dar, das über Verstärker motiviert werden kann.

Was bedeutet das für die Akquisitionsraten und damit für die Lerngeschwindigkeit?

Bei der Akquisitionsrate im Rahmen der Konditionierung scheint es also weniger darum zu gehen, dass ein Lebewesen ein bestimmtes Verhalten erlernt oder erwirbt, sondern darum, die Kette aus Hinweisreiz, Verhalten und Verstärker zu erkennen. Es geht um das Erlernen, ob und wann es sich lohnt, ein bestimmtes Verhalten zu zeigen oder zu performen und weniger darum, das bestimmte Verhalten zu erlernen: Auf einen Knopf picken, kann jede Taube und jeder Hund kann auch generell eine sitzende Position einnehmen. Insofern haben Verstärker rein motivierende Wirkung, ein Verhalten zu zeigen. Natürlich stellt das Lernen selbst ein Verhalten dar, das über Verstärker motiviert werden kann.

Drei Theorien zur Extinktionsrate – selbes Ergebnis

Diese Idee scheint auch in der von Mowrer und Jones 1945 formulierten Diskriminationshypothese durch. Dieser zur Folge tritt eine Verhaltensänderung erst dann, wenn eine Verstärkungskontingenzänderung erkannt wird. Die Änderung in der Verstärkungskontingenz dient als Hinweis- oder Diskriminationsreiz für die Verhaltensänderung. Dies bezieht sich sowohl auf die Akquisition als auch auf die Löschung: Je seltener eine Verstärkung erfolgt, desto länger dauert es, bis ein Zusammenhang zwischen einem bestimmten Verhalten und der Verstärkung erkannt und das Verhalten als lohnenswert eingestuft wird, wodurch die Akquisitionsrate gegenüber Verstärkerplänen mit häufigerer Verstärkung abnimmt. Allerdings dauert es auch umso länger, bis eine erneute Änderung der Verstärkungskontingenzen, im Falle der Löschung ist das der Wegfall der Verstärkung, erkannt wird. Durch die verzögerte Wahrnehmung dieser Änderung, die als Hinweisreiz für eine erneute Verhaltensänderung, nämlich der Löschung, dient, wird das Verhalten auch ohne Verstärker länger gezeigt, womit es löschungsresistenter ist.