Operante Konditionierung

Was ist operante Konditionierung, wie lautet ihre Definition und wie wird sie eingesetzt?

Von:

Ulf Weber

Zuletzt aktualisiert am: 15.12.2024

Die operante Konditionierung ist eine vom amerikanischen Verhaltenspsychologen B. F. Skinner in den 1930er entwickelte Lerntheorie. Du willst wissen, was sie ausmacht, warum und wie sie funktioniert? Hier findest Du die operante Kondition samt Definition. Auch ihre Gesetze werden einfach erklärt und mit vielen Beispielen belegt.

Inhaltsverzeichnis:

- Die Operante Konditionierung - einfach erklärt

- Operante Konditionierung – Definition – wie lautet sie?

- Die operante Konditionierung und ihre Gesetze im Schema einfach erklärt

- Die Operante Konditionierung als Schema im Kontingenzschema

- Burrhus Frederic Skinner, die Skinner-Box und die Erfindung der operanten Konditionierung

- Die Skinner-Box

- Operante Konditionierung – Versuch Skinners zu

- Positive Verstärkung

- Negative Verstärkung

- Positive Bestrafung

- Negative Bestrafung

- Grundprinzip der operanten Konditionierung: Verstärker bzw. Verstärkung, Bestrafung und Extinktion im Beispiel

- Positive Verstärkung

- Negative Verstärkung

- Positive Bestrafung

- Negative Bestrafung

- Häufigkeit der Verstärker – Was ist ein Verstärkerplan?

- Kontinuierliche Verstärkung oder Immer-Verstärkung

- Intermittierende Verstärkung

- Wie wendet man Verstärkerpläne in der operanten Konditionierung am besten an?

- Arten der Verstärker für die operante Konditionierung

- Primär-Verstärker & operante Konditionierung

- Sekundär-Verstärker& operante Konditionierung

- Materieller Verstärker & operante Konditionierung

- Handlungs-Verstärker & operante Konditionierung

- Soziale Verstärker & operante Konditionierung

- Wovon hängt die Wirkung der Verstärker in der operanten Konditionierung ab?

- Weitere Fachbegriffe und Prinzipien der operanten Konditionierung

- Extinktion bzw. Löschung und der Extinktionsausbruch

- Wie wirken Verstärkerpläne auf Extinktion und Löschung?

- Operantes Konditionieren in praktischer Anwendung – Was ist Shaping?

- Beispiele operanter Konditionierung: Wie wird operantes Konditionieren angewendet?

- Wie wird operantes Konditionieren in der Verhaltenstherapie angewendet?

- Kann man mit Löschung und Extinktion operante Konditionierung rückgängig machen?

- Wie kann man eine operante Konditionierung rückgängig machen?

- Mit welchen Verstärkerplänen wird operantes Konditionieren in der Schule, der Kita und Kindererziehung angewendet?

- Operantes Konditionieren in Hundeerziehung, Hundetraining und Tiertraining

- Wie wird operantes Konditionieren in der Verhaltenstherapie angewendet?

- Was ist der Unterschied zwischen operanter, instrumenteller und klassischer Konditionierung?

- Was führt bei der operanten Konditionierung zu Kritik?

- Fazit

1. Die Operante Konditionierung - einfach erklärt

Die operante Konditionierung ist eine Lerntheorie des Behaviorismus. Sie beschreibt im Kern, dass Menschen und Tiere lernen, belohntes Verhalten künftig öfter zu zeigen und bestraftes Verhalten seltener. Das künftige Verhalten hängt also von den Konseqeuenzen des Verhaltens ab.

Schenkst Du zum Beispiel jemandem etwas (Verhaltensweise) und derjenige dankt Dir freudig (Lob bzw. angenehme Konsequenz), wirst Du gerne wieder was schenken. Beschwert derjenige sich aber (Strafe bzw. unangenehme Konsequenz) über das „falsche“ Geschenk, wirst Du vielleicht kein weiteres Mal ein Geschenk machen.

Für die operante Konditionierung ist kein Lehrer oder Trainer notwendig. Das verdeutlicht das folgende Beispiel.

Stützt Du Dich achtlos auf eine Herdplatte (Verhalten) und verbrennst Dir die Finger (Strafe bzw. unangenehme Konsequenz), wirst Du künftig nicht mehr achtlos auf eine solche fassen.

In der operanten Konditionierung wird die Verbindung aus Verhalten und Konsequenz hochwissenschaftlich auch als Reaktion-Reiz-Kopplung bezeichnet.

2. Operante Konditionierung – Definition – wie lautet sie?

Die Operante Konditionierung ist eine Lerntheorie des Behaviorismus. Sie beschreibt, wie die Konsequenz eines Verhaltens die Auftretenshäufigkeit des Verhaltens beeinflusst mit folgenden Regeln:

Ein Verhalten, auf das der Beginn eines angenehmen Reizes (= positive Verstärkung) oder das Ende eines unangenehmen Reizes (= negative Verstärkung) als Konsequenz folgt, wird künftig häufiger gezeigt.

Ein Verhalten, auf das der Beginn eines unangenehmen Reizes (= positive Bestrafung) oder das Ende eines angenehmen Reizes (= negative Bestrafung) als Konsequenz folgt, wird künftig seltener gezeigt.

3. Die operante Konditionierung und ihre Gesetze im Schema dargestellt

Die Gesetze der operanten Konditionierung bezüglich Verstärkung und Bestrafung lassen sich in einem Schema darstellen. Das Kontingenzschema der operanten Konditionierung stellt den Zusammenhang aus Verhalten und Konsequenz dar.

| Konsquenz oder Reiz... | ...beginnt | ...endet |

| ...ist angenehm | Positive Verstärkung – Verhalten wird häufiger | Negative Bestrafung – Verhalten wird seltener |

| ...ist unangenehm | Positive Bestrafung – Verhalten wird seltener | Negative Verstärkung – Verhalten wird häufiger |

4. Burrhus Frederic Skinner, die Skinner-Box und die Erfindung der operanten Konditionierung

Häufig werden B. F. Skinner und die operante Konditionierung in einem Atemzug genannt. Denn Skinner begründete die operante Konditionierung durch seine Verhaltensforschung. Diese betrieb er ab den 1930er Jahren zumeist an Tauben oder Ratten, deren Verhalten er in der sogenannten „Skinner-Box“ experimentell erforschte.

Skinner knüpfte dabei an die Forschung von Edward Lee Thorndike und seine instrumentelle Konditionierung an.

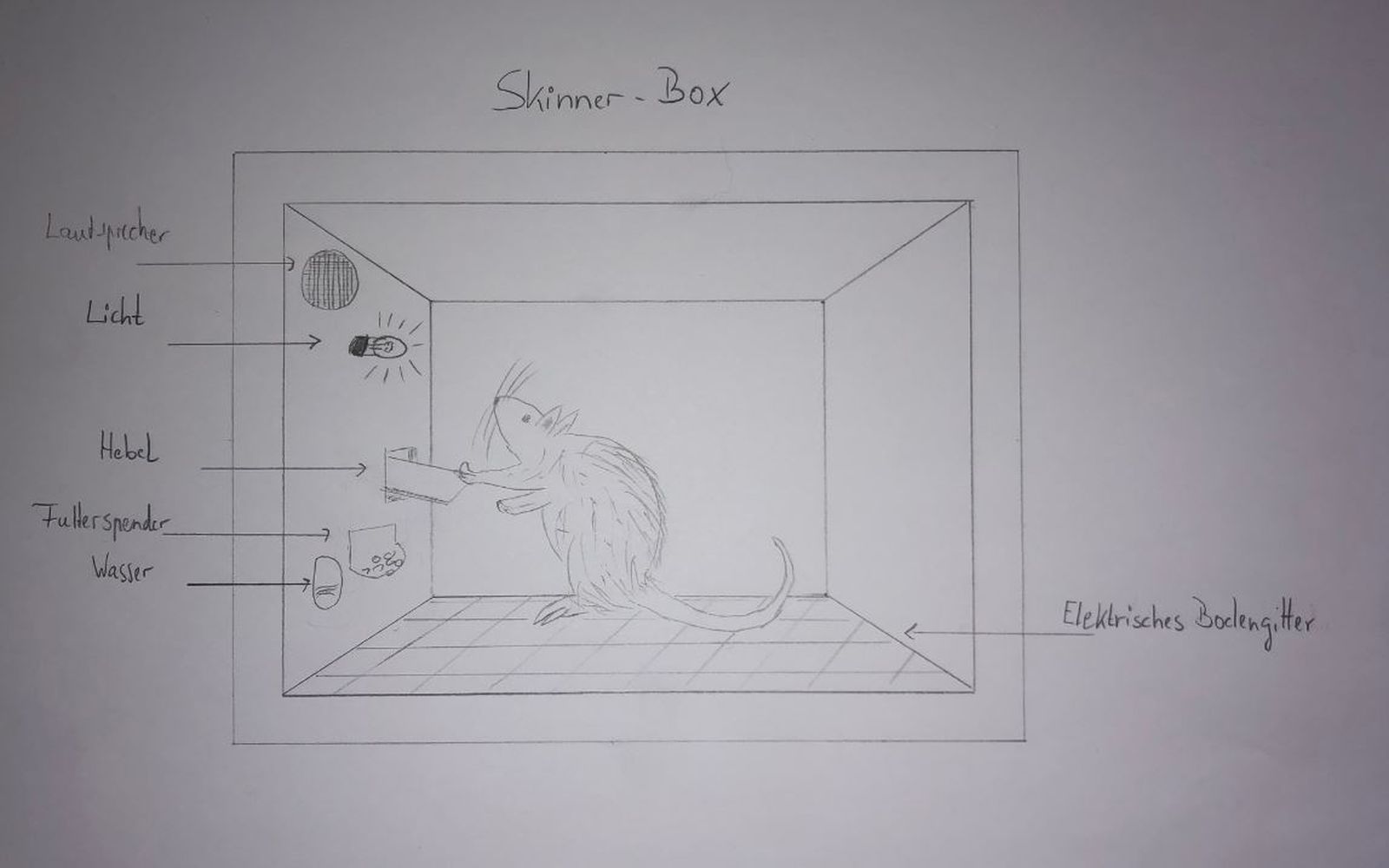

4.1 Die Skinner-Box

Bei der Skinner-Box handelt es sich um eine Art Käfig. In diesen setzte Skinner Ratten und Tauben. In der ursprünglichen Skinnerbox konnten die Versuchstiere zwei verschiedenen Reizen ausgesetzt werden. Denn den Tieren konnte durch den leitfähigen Boden ein Stromschlag und durch einen Automaten eine Futterportion geben werden.

Darüber hinaus war ein Hebel für die Ratten und eine Pickfläche für die Tauben angebracht. Mit dieser Konfiguration einer Skinner-Box führte Skinner die unten beschriebenen Versuche durch und begründete die operante Konditionierung.

Um die Theorie weiter zu erforschen, wird eine Skinner-Box mit weiteren Reizquellen versehen. Verbreitet sind

- leitfähiger bzw. elektrischer Boden

- Futterspender

- ein oder mehrere Glühbirnchen in verschiedenen Farben

- ein Lautsprecher.

4.2 Operante Konditionierung – Versuch Skinners

Für den ersten „Operante Konditionierung Versuch“ Skinners setzte er Tauben in eine Skinner-Box und wartete ab, bis diese mit dem Schnabel auf die Schaltfläche pickten.

4.2.1 Positive Verstärkung

Immer, wenn die Taube auf Schaltfläche pickte (Verhalten), löste sie damit den Automaten aus und es wurde ihr Futter gegeben (angenehmer Reiz als Konsequenz). In der Folge pickte sie immer öfter auf die Schaltfläche.

Das Verhalten tritt häufiger auf weil es positiv verstärkt wurde.

4.2.2 Negative Verstärkung

Jetzt steht der Boden der Skinner-Box dauerhaft unter Strom (unangenehmer Reiz). Immer, wenn die Taube auf Schaltfläche pickte (Verhalten), schaltet sie damit für eine Zeit den Strom ab (unangenehmer Reiz endet als Konsequenz). In der Folge pickte sie immer öfter auf die Schaltfläche.

Das Verhalten tritt häufiger auf, weil es negativ verstärkt wurde.

4.2.3 Positive Bestrafung

Immer, wenn die Taube auf Schaltfläche pickte (Verhalten), schloss sie damit den Stromkreis und erhielt über den Boden einen Stromschlag (unangenehmer Reiz als Konsequenz). In der Folge pickte sie immer seltener auf die Schaltfläche.

Das Verhalten tritt seltener auf, weil es positiv bestraft wurde.

4.2.4 Negative Bestrafung

Jetzt steht dauerhaft Futter in der Skinner-Box zur Verfügung (angenehmer Reiz). Immer, wenn die Taube auf Schaltfläche pickte (Verhalten), wird der Futternapf verdeckt und das Futter entzogen (angenehmer Reiz endet als Konsequenz). In der Folge pickte sie immer seltener auf die Schaltfläche.

Das Verhalten tritt seltener auf, weil es negativ bestraft wurde.

5. Grundprinzip der operanten Konditionierung: Verstärker bzw. Verstärkung, Bestrafung im Beispiel

5.1 Beispiel aus dem Alltag: Positive Verstärkung

Du machst Hausaufgaben (Verhalten) und bekommst dafür immer Lob und eine gute Note vom Lehrer (angenehme Konsequenz).

Du machst öfter Hausaufgaben.

5.2 Beispiel aus dem Alltag: Negative Verstärkung

Du hast einen Splitter im Finger. Du entfernst ihn mit einer Pinzette (Verhalten) und der Schmerz endet (unangenehmer Reiz endet als Konsequenz).

Du überwindest öfter Deine Angst und ziehst Dir die Splitter.

"Positiv" bedeutet, dass ein Reiz beginnt.

"Negativ", dass einer endet.

5.3 Beispiel aus dem Alltag: Positive Bestrafung

Du fährst freihändig Fahrrad (Verhalten) und verletzt Dich dabei häufig schmerzhaft (unangenehmer Reiz als Konsequenz).

In der Folge fährst Du seltener freihändig.

5.4 Beispiel aus dem Alltag: Negative Bestrafung

Wenn Du zu schnell Auto fährst (Verhalten), wird dir der Führerschein entzogen (angenehmer Zustand oder Reiz endet als Konsequenz).

In der Folge fährst Du seltener zu schnell.

6. Häufigkeit der Verstärker – Was ist ein Verstärkerplan?

Als Verstärkerplan wird das Muster bezeichnet, das die Häufigkeit einer Konsequenz beschreibt. Denn nicht immer, wenn wir ein bestimmtes Verhalten zeigen, ist die Konsequenz dieselbe. Somit treten unterschiedliche Konsequenzen unterschiedlich häufig und nach unterschiedlichen Mustern ein.

Der Begriff wird deshalb verwendet, weil der Verstärkerplan von einem Lehrer oder Trainer bewusst festgelegt wird und dann tatsächlich ein Plan ist. Das Muster kann aber auch unbewusst entstehen und wird auch dann noch Verstärkerplan genannt.

Beispielsweise wird nicht jeden Tag der Gang zum Briefkasten (Handlung) mit netter Post (Reiz) verstärkt. Ob und wann Briefe kommen, unterliegt keinem bewusst erstellten Verstärkerplan.

Grundsätzlich werden Verstärkerpläne mit kontinuierlicher von solchenmit intermittierender Verstärkung unterschieden werden.

6.1 Kontinuierliche Verstärkung oder Immer-Verstärkung

Bei einem Verstärkerplan mit kontinuierlicher Verstärkung wird das erwünschte Verhalten jedes Mal verstärkt. Wird ein Verhalten immer belohnt oder verstärkt, lernt das Lebewesen sehr schnell, welches Verhalten die Belohnung bringt.

Wird später das Verhalten nicht mehr belohnt, weil es als „gelernt“ angesehen wird zeigt sich der Nachteil der kontinuierlichen Verstärkung. Denn leider erkennt und lernt das Lebewesen aber ebenso schnell, dass es für das Verhalten nicht mehr belohnt wird, wenn die Verstärkung nicht mehr auf das Verhalten folgt. In dem Fall wird das Verhalten nicht verlernt. Vielmehr wird gelernt, dass dem Verhalten kein Verstärker mehr folgt und es sich daher nicht mehr lohnt.

Wissenschaftlich ausgedrückt wird aber die durch die operante Konditionierung entstandene Reaktion-Reiz-Kopplung gelöscht. Daher spricht man auch von Extinktion oder Löschung.

6.2 Intermittierende Verstärkung

Um eine intermittierende Verstärkung zu ermöglichen, existieren vier verschiedene Arten von Verstärkerplänen. Allen gemeinsam ist, dass hier das gewünschte Verhalten nicht jedes Mal belohnt wird, sondern nach einem mehr oder weniger komplizierten Muster.

Die folgende Tabelle zeigt die vier Grundtypen der Verstärkerpläne.

| ...Quotenversrärkung | ...Intervallverstärkung | |

| fixe... |

Verstärkung erfolgt nach einer festen Anzahl an Wiederholungen des Verhaltens.

Bsp. für feste Quote von 5: Lehrer vergibt eine gute Mitarbeitsnote immer, wenn ein Schüler sich 5mal gemeldet hat. |

Verstärkung erfolgt nach einer festen Zeit, während der das Verhalten ausgeübt wird.

Bsp.: Elternteil lobt Kind alle 15 Minuten, wenn es ruhig und konzentriert Hausaufgaben macht. |

| variable... |

Verstärkung erfolgt durchschnittlich nach X Wiederholungen des Verhaltens.

Bsp. für variable Quote von 5: Ein Schüler meldet sich 50 mal. Der Lehrer hat die ersten 5 Beiträge und die letzten 5 je eine gute Mitarbeitsnote vergeben. Im Durchschnitt wurden 10/50 = 1/5 also jeder 5. Beitrag mit einer guten Note versehen. Aber zwischendurch eben eine ganze Reihe nicht. |

Verstärkung erfolgt höchsten X-Mal in einer bestimmten Zeitspanne.

Bsp.: Elternteil lobt Kind durchschnittlich viermal pro Stunde, wenn es ruhig und konzentriert Hausaufgaben macht. Im Durchschnitt wird also alle 60 /4= alle 15 Minuten gelobt.

Allerdings kommt das erste Lob schon nach 10 Minuten und in den letzten 15 Minuten wird das Kind dreimal gelobt. Während der 35 Minuten dazwischen wird nicht gelobt. |

Generell gilt: Je komplexer das Muster, desto

- schwerer ist es erkennbar.

- niedriger ist die Akquisitionsrate und länger dauert die Lernphase oder Akquisitionsphase.

- schwerer ist später erkennbar, dass die Verstärkung nicht mehr auf das Verhalten folgt.

- länger dauert die Löschung bzw. die „Verlern-Phase“ oder Extinktionsphase.

- löschungsresistenter ist die durch operante Konditionierung entstandene Reaktions-Reiz-Kopplung.

Besonders kompliziert zu erkennen ist die Verstärkung nach variablen Quotenplänen. Dies gilt besonders, wenn die geforderte Wiederholungsquote recht hoch ist. Daher ist ein Verhalten, das mit einem solchen Plan verstärkt wird, besonders löschungsresistent. Als Beispiel eines solchen Verhaltens gilt die Spielsucht. Denn hier wird das Verhalten „Spielen“ nach einem für die Spieler nicht erkennbarem Muster mit einem Gewinn belohnt.

6.3 Wie wendet man Verstärkerpläne in der operanten Konditionierung am besten an?

Die kontinuierliche Verstärkung weist ebenso wie die verschiedenen intermittierenden Verstärkerpläne Vor- und Nachteile auf. Kombinierst Du die kontinuierliche Verstärkung mit einer variablen Quotenverstärkung, kannst Du die Vorteile beider miteinander verbinden.

Verwendest Du zunächst die Immer-Verstärkung, sorgt das für eine steile Lernkurve mit schnellen Lernerfolgen. Schwenkst Du später auf ein variable Quotenverstärkung um, nimmt zwar die Lernkurve ab, aber das Verhalten wird gefestigt.

Ein Anwendungsbeispiel hierfür ist die 300-Pickmethode für das Tier- und Hundetraining.

7. Arten der Verstärker für die operante Konditionierung

Skinner sagte, dass jeder Reiz, der ein Verhalten öfter auftreten lässt, ein Verhaltensverstärker sei. Da man aber gerne im Vorfeld wüsste, was als Verhaltensverstärker verwendet werden kann, wurde hierzu viel geforscht und experimentiert.

Hierdurch wurden zunächst Gruppen von Verstärkerarten gebildet. Manche Gruppen (z. B. primäre und sekundäre Verstärker aber auch materielle und Handlungsverstärker) schließen sich gegenseitig aus.

Dennoch können Verstärker mehreren Gruppen angehören. So gehört Geld als Lohn zur Kategorie der Sekundär-Verstärker und der materiellen.

Im Ergebnis können folgende Gruppen gebildet werden:

7.1 Primär-Verstärker & operante Konditionierung

Als Primär-Verstärker können Dinge verwendet werden, die überlebenswichtige, physiologische Grundbedürfnisse decken. Zu nennen sind Futter oder Nahrung, Wasser, Sauerstoff, Schmerzfreiheit, Schutz vor Kälte/Wärme/Gewalt. Ihnen gegenüber stehen die sekundären Verstärker.

7.2 Sekundär-Verstärker& operante Konditionierung

Sekundär-Verstärker sind solche Dinge, die nicht lebensnotwendig sind. Sie wurden auf Grund eines Lernvorgangs zur Belohnung. Hierzu zählen neben Geld auch Lob, Schulnoten oder Befugnisse wie der Führerschein. Ihnen stehen die primären Verstärker gegenüber.

Das bekannteste Beispiel eines Sekundärverstärkers aus der Hundeerziehung und dem Hundetraining ist der Clicker. Dieser hat zunächst für den Hund keine belohnende Bedeutung und wird über klassische Konditionierung mit der belohnenden Bedeutung von Futter gekoppelt.

7.3 Materieller Verstärker & operante Konditionierung

Materielle Verstärker sind Dinge, die von Schokolade oder Nahrung bis zu Geld und Spielzeug reichen können. Sie können sowohl daher sowohl primäre als auch sekundäre Verstärker sein. Ihnen stehen aber die Handlungsverstärker gegenüber.

7.4 Handlungs-Verstärker & operante Konditionierung

Ein Handlungsverstärker ist ein Verstärker, der nicht Dinglich ist. Vielmehr beruht er auf der Möglichkeit, eine bestimmte Handlung als Belohnung auszuführen. Dies spielt vor allem bei Verhaltensketten eine Rolle. Denn hier ist die Möglichkeit für die nächste Handlung den Verstärker für die Vorangehende.

Im Alltag kannst Du aber ein gemeinsames Spiel mit Deinem Hund zu dessen Belohnung für eine gute Trainingseinheit oder einen Kinobesuch mit Deinem Kind für eine Woche tadellosen Verhaltens unternehmen.

7.5 Soziale Verstärker & operante Konditionierung

Bei sozialen Verstärkern geht es um die Anerkennung anderer. Sie können in einem Lob, in Lachen, Lächeln, Beifall oder gemeinsam verbrachte Zeit bestehen.

8. Wovon hängt die Wirkung der Verstärker in der operanten Konditionierung ab?

Die Wirksamkeit eines Verstärkers bestimmt, wie stark er das Auftreten eines Verhaltens beeinflusst. Ist die Wirksamkeit des Verstärkers hoch, lernt das Lebewesen schnell. Ist die Wirksamkeit niedrig oder eignet sich etwas gar nicht als Verstärker, lernt es langsamer oder gar nicht.

Die Wirksamkeit hängt von folgenden Kriterien ab.

8.1 Zeitlicher Zusammenhang

Der zeitliche Zusammenhang zwischen Verhalten und belohnender Verstärkung ist nicht nur im Tiertraining und der Hundeerziehung wichtig. Dort muss die Belohnung binnen einer Sekunde nach dem Verhalten erfolgen. Dieser Umstand führte zur Entwicklung des Clickers, mit dem diese Reaktionszeiten leichter zu erreichen sind.

Aber auch für die meisten Schüler ist der Spruch „Du lernst fürs Leben“ und die damit verbundenen späten Verstärker zu abstrakt, um kontinuierlich zu lernen. Viele lernen eher für kurzfristig erreichbare Verstärker wie die Erlaubnis, am Wochenende mit Freunden ins Kino zu dürfen.

8.2 Charakterlich-persönliche Kriterien:

Auch diese Kriterien sind keine rein menschlichen. Selbst bei Tieren und Hunden ist es so, dass nicht jedes Futter auf einen bestimmten Hund belohnend wirkt: Der eine mag eher Wildgeschmack, der andere mag Leberwurst aus der Tube oder Käse.

So ist es auch beim Menschen: Wenn Du kein Eis magst, wird es auf Dich auch nicht belohnend wirken.

8.3 Bedürfnis-Situation

Auch diese ist sehr individuell. Stell Dir vor, Du hast gerade ausgiebig zu Mittag gegessen und bist pappsatt. Dann ist Dein Bedürfnis nach Nahrung so gering, dass Du ein großes Eis nicht besonders belohnend wirken wird. Entsprechend groß ist der Einfluss der Bedürfnisse auf die Wirksamkeit eines Verstärkers.

8.4 Erlernte Faktoren wie kultureller Einfluss, Sozialisation, Prestige der Lobenden

Hier geht es um, teilweise durch Konditionierung, erlernte Faktoren.

Kulturelle Einflüsse treffen alle Arten von Verstärkern, auch Primärverstärker. Denn beispielsweise sind Milch und Käseprodukte in China nicht so beliebt, wie bei uns. Ein Schimmelkäse, der hier als Delikatesse und Nahrungsmittel gilt, wird dort bestenfalls neutral betrachtet. Als belohnender Verstärker kann er dort kaum wirken. Umgekehrt wirkt nicht jedes fernöstliche Essen auf einen Mitteleuropäer angenehm und belohnend.

Eng daran liegt die Sozialisation. Manche Menschen sind zum Beispiel so erzogen, dass sie ungern im Mittelpunkt stehen. Eine öffentliche Ehrung wirkt für diese vielleicht nicht wie ein sozialer Verstärker, sondern eher wie ein bestrafender Stressor. Auch auf Hunde und Tiere wirkt die Sozialisierung und Erfahrung. Ist ein Hund oft von anderen gebissen worden, stellt eine Hundebegegnung keine belohnende Spiel-Situation dar, sondern ein Angst-Szenario.

Bei Lob und Anerkennung kommt es darauf an, wer das Lob und die Anerkennung spendet. Je höher Du die lobende Person oder Personengruppe schätzt, desto verstärkender wirkt das Lob. Beispielweise zählt ein Lob vom Lieblingslehrer oder der Lieblingslehrerin mehr als das von einem weniger beliebten Lehrkörper.

9. Weitere Fachbegriffe und Prinzipien der operanten Konditionierung

9.1 Extinktion bzw. Löschung und der Extinktionsausbruch

Eine Extinktion oder Löschung tritt ein, wenn dem bisher verstärkten Verhalten keine belohnende Verstärkung mehr folgt.

Der Begriff der Extinktion legt nahe, dass es sich hierbei um eine Art des Vergessens oder des Verlernens handelt, indem eine Verhaltens-Konsequenz-Kopplung gelöscht wird. Tatsächlich „lernt“ aber das Lebewesen, dass das Verhalten sich nicht mehr lohnt, weil es keinen belohnenden Verstärker mehr erzeugt.

Vor allem im Fall einer vorangegangenen Immer-Verstärkung lässt sich Prozess der Extinktion gut erkennen. Folgt dem Verhalten plötzlich keine belohnende Verstärkung, wird dieses Verhalten erstmal öfter als vorher und teilweise in Varianten gezeigt. Grund hierfür ist das Verlangen nach dem Verstärker. Erst dann wird das konditionierte Verhalten immer seltener und irgendwann gar nicht mehr gezeigt.

Stell Dir als Beispiel vor, dass Du morgens Dein Auto starten willst. Du drehst den Zündschlüssel um, aber der Wagen macht keinen Mucks. Hier ist das Drehen des Schlüssels das Verhalten, das Anspringen des Motors der Verstärker. In der Folge wirst Du wahrscheinlich noch mehrfach versuchen, den Schlüssel zu drehen und den Wagen zu starten. Das ist der Extinktionsausbruch, den Du zeigst, bevor Du akzeptierst, dass der Wagen so nicht starten wird. Dann zeigst Du Verhaltensvarianten und schlägst vielleicht mal auf das Armaturenbrett in der Hoffnung, einen Wackelkontakt zu schließen und drehst nochmal den Schlüssel um, bevor Du das Verhalten einstellst.

9.2 Wie wirken Verstärkerpläne auf Extinktion und Löschung?

Das oben beschriebene Beispiel einer Extinktion bezieht sich auf operantes Konditionieren mit einer kontinuierlichen Verstärkung. Durch diese lässt sich für das lernende Lebewesen leicht der Zusammenhang (= Kontingenz) zwischen dem speziellen Verhalten und dem Verstärker erkennen. Somit wird die Verhaltens-Verstärker-Kopplung schnell erkannt und aufgebaut. Ebenso schnell wird aber auch erkannt, dass der Verstärker dem Verhalten nicht mehr folgt. Daher verläuft die Löschung recht zügig nach dem obigen Schema.

Entsprechend wirkt sich ein Verstärkerplan mit komplexerem Muster aus. Wird z. B. eine variable Quotenverstärkung, gewählt, dauert der Aufbau der Verhaltens-Konsequenz-Kopplung länger. Allerdings wird auch der Wegfall der Konsequenz viel langsamer erkannt. Daher dauert die Löschung länger oder tritt gar nicht ein.

Als Beispiel kann hier die Spielsucht gelten. Automaten und Casinos verstärken das Verhalten „Spielen“ sehr unregelmäßig und selten. Bei Spielern, die ihr gesamtes Vermögen verspielen, zeigt sich das besonders deutlich: Sie spielen weiter, weil sie vielleicht doch mal gewinnen könnten und bemerken nicht, dass dieser Verstärker nicht eintritt.

10. Operantes Konditionieren in praktischer Anwendung – Was ist Shaping?

Aus den wissenschaftlichen Ansätzen der operanten Konditionierung haben sich heute greifbare Lehr- und Trainingsmethoden entwickelt. Neben Capturing, Target-Training und Chaining ist das Shaping die bekannteste Methode der operanten Konditionierung.

Beim Shaping (engl. für „formen“) wird Verhalten geformt. Dazu wird jede kleinste Annäherung an das gewünschte Verhalten positiv verstärkt und belohnt. Das Shaping spielt in der Verhaltenspsychologie und -therapie, aber vor allem im Tier- und Hundetraining eine große Rolle. Es bringt den Vorteil mit, dass komplexes Verhalten in kleinste, vom Lernenden freiwillig vorgegebene Teilschritte zerlegt wird. Diese zeigt der Lernende von selbst und erhält dafür eine Belohnung.

Willst Du Deinem Hund zum Beispiel eine Seitwärtsrolle beibringen, könnte das so aussehen: Der Hund setzt sich, Du verstärkst das. Wenn der Hund sich häufiger hinsetzt, wartest Du, bis er ein weiteres Verhalten anbietet und sich z. B. hinlegt. Das wird dann so lange verstärkt, bis er sich häufig hinlegt. Neigt der Hund sich liegend einer Seite zu, verstärkst Du ab jetzt nur noch das. Nimmt er bald zügig diese Position ein, verstärkst Du ihn nur noch, wenn er sich weiter in die Richtung bewegt. Nach diesem Schema gehst Du vor, bis der Hund eine komplette Rolle macht.

11. Beispiele operanter Konditionierung: Wie wird operantes Konditionieren im Alltag angewendet?

Die operante Konditionierung ist noch heute im Alltag zu beobachten. Einerseits, weil man sie einen praktisch nachvollziehbaren Ansatz bietet, das Entstehen von Verhalten zu erklären. Aber auch, weil sie von Eltern, Erziehern, Lehrern, Therapeuten und Trainern für Mensch und Tier noch immer eingesetzt wird. Die folgenden Beispiele sollen dies verdeutlichen

11.1 Wie wird operante Konditionierung in der Therapie angewendet?

In der psychologischen Therapie wird operantes Konditionieren häufig eingesetzt, um krankhaftes Verhalten zu verändern. Hierbei kann das krankhafte Verhalten teilweise als operant konditioniertes Verhalten begriffen werden (siehe oben z. B. Spielsucht).

Für den Fall stellt sich die Frage, wie operant konditioniertes Verhalten rückgängig gemacht werden kann.

11.1.1 Kann man mit Löschung und Extinktion operante Konditionierung rückgängig machen?

Nahe liegt der Versuch, konditioniertes (Fehl-)Verhalten durch Löschung bzw. Extinktion therapeutisch rückgängig zu machen. Das funktioniert wegen folgender Gründe in der Praxis selten:

- Die Verstärkerpläne sind häufig zu komplex, als dass Extinktion in absehbarer Zeit funktioniert

- Die Quellen der belohnenden Verstärker sind nicht alle kontrollierbar

Beispiel: Zeigt ein Mensch ein Fehlverhalten, um damit Anerkennung anderer Menschen zu erhalten, kann kein Therapeut oder Lehrer verhindern, dass nicht doch irgendjemand anerkennend oder auch nur mit Aufmerksamkeit auf das zu löschende Fehlverhalten reagiert.

11.1.2 Wie kann man eine operante Konditionierung rückgängig machen?

Um operantes Konditionieren rückgängig zu machen, weil es sich um ein krankhaftes und schädliches Verhalten handelt, kann auf die differentielle Konditionierung zurückgegriffen werden.

Darunter wird eine Kombination aus Extinktion des unerwünschten bei gleichzeitiger positiver Verstärkung eines gewünschten Alternativverhaltens verstanden.

11.2 Mit welchen Verstärkerplänen wird operantes Konditionieren in der Schule, der Kita und Kindererziehung angewendet?

In der Schule finden sich viele Beispiele operanter Konditionierung. Schon eine gute Schulnote kann als positive Verstärkung mit einem Sekundärverstärker betrachtet werden.

Darüber hinaus wenden Grundschullehrende gerne Varianten des Token-Systems an. „Token“ ist ein englisches Wort und bezeichnet einen Gutschein. Hierbei wird für gewünschtes Verhalten (ruhiges, konzentriertes Lernen mit viel Mitarbeit z. B.) einzelner Schüler oder der gesamten Klasse Symbole wie Smileys, Stern oder sonstiges vergeben. Gleichzeitig wird an bestimmte Mengen dieser Symbole eine wirkliche Belohnung gehangen.

Beispielsweise könnte für eine Grundschul-Klasse gelten, dass sie für jede Stunde, in der sie ruhig und konzentriert mitarbeitet, einen Stern erhält. Sind 50 Sterne erreicht, geht die Klasse gemeinsam Eisessen.

11.3 Operantes Konditionieren in Hundeerziehung, Hundetraining und Tiertraining

Auch in der Hundeerziehung und im Hundetraining ist operantes Konditionieren weit verbreitet. Denn immer, wenn wir den Hund mit Leckerchen belohnen, wenden wir die positive Verstärkung an.

Aber auch die negative Verstärkung wenden viele Hundemenschen an. Wird ein Hund ins Sitz gebracht, indem der Hundemensch mit dem Finger leichten Druck auf den Schanzansatz ausübt, ist das ein klassisches Beispiel für die negative Verstärkung. Denn der unangenehme Reiz des Drucks auf die Wirbelsäule wird beendet, wenn der Hund sich hinsetzt.

Der Lexikonbeitrag „Trainingsmethoden“ stellt darüber hinaus viele moderne Methoden vor, die auf operanter Konditionierung beruhen.

12 Was ist der Unterschied zwischen operanter, instrumenteller und klassischer Konditionierung?

Neben der operanten Konditionierung besteht die klassische und die instrumentelle Konditionierung.

Der Hauptunterschied zwischen klassischer Konditionierung auf der einen und operanter sowie instrumenteller Konditionierung ist recht einfach. Bei der klassischen Konditionierung werden zwei Reize miteinander gekoppelt und führen nach der Konditionierung zur selben unbewussten, reflexhaften Reaktion.

Im Gegensatz dazu werden bei der instrumentellen und der operanten Konditionierung „bewusste“ Reaktionen und Verhaltensweisen an Reize gekoppelt, die als Konsequenz auftreten.

Dies ist bei operanter und instrumenteller Konditionierung gleich. Daher ähneln sie sich sehr. Sie werden daher in der Tabelle unten gegenübergestellt. Eine entsprechende Gegenüberstellung für die operante Konditionierung und die klassische Konditionierung findet sich auf der Lexikonseite der klassischen Konditionierung.

| Merkmal | Insrtrumentelle Konditionierung | operante Konditionierung |

| Begründer/Entdecker | Edward Lee Thorndike | B. F. Skinner |

| Entwicklungszeit | ca. 1900 | ca. 1930 |

| Gemeinsamkeit | "erfolgreiches" Verhalten wird öfter gezeigt | "erfolgreiches" Verhalten wird öfter gezeigt |

| Zentrale Thesen / Prinzipien |

Gesetz der Wirkung |

Das Kontingenzschema aus: Positive Verstärkung |

| Kernunterschied ist das Gesetz der Bereitschaft und das Kontingenzschema | Thorndike versteht Verhalten als Instrument zur Problemlösung oder Zielerreichung. Nur wenn ein Problem gelöst werden soll, zeigt ein Lebewesen Verhalten und ist bereit zum Lernen | Skinner sieht, dass Lebewesen sich ständig irgendwie verhalten und damit "operieren": Sie brauchen hierzu keinen Grund. Allerdings zeigen sie Verhalten, dass sich als „erfolgreich“ erwiesen hat, öfter und bestrafetes seltener. |

13. Welche Vor- und Nachteile existieren und führen bei der operanten Konditionierung zu Kritik?

Die operante Konditionierung ist Teil der verhaltenspsychologischen Schule des Behaviorismus. Dies trifft zwar auch für die beiden anderen Arten der Konditionierung zu. Allerdings steht der Begründer der operanten Konditionierung, Burrhus Frederic Skinner, für die radikalste Ausprägung der Strömung.

Skinners radikaler Behaviorismus betrachtet Lebewesen gleichsam als Reiz-Reaktion-Reiz-Automaten.

Schon diese Reduzierung komplexer Lebewesen ist ein Nachteil und führt zu Kritik. Denn sie lässt viele Aspekte, die Verhalten beeinflussen, außer Acht. Zu nennen wären hier Instinkte oder auch menschliche Gefühle.

Skinner hat durchaus bewiesen, dass er mit operantem Konditionieren Verhalten bis ins kleineste Detail so gestalten kann, wie er es beabsichtigt. Aber ein nach seinem Verständnis perfektes Verhalten zeigender Mensch kann dennoch todunglücklich sein und Skinner würde es nicht einmal bemerken: Denn er könnte den Menschen so konditionieren, dass er seine Gefühle nicht zeigt.

Darüber hinaus schwebte Skinner die perfekte Gesellschaft vor. Diese sollte mit seiner operanten Konditionierung geformt werden.

In dem Fall stellt sich die Frage, wer denn eigentlich festlegt, was ein wünschenswertes Verhalten ist. Im Falle unserer Hunde ist diese Frage allgemein anerkannt. Aber die Erziehung deutscher Soldaten zur Unmenschlichkeit durch die Naziideologie im zweiten Weltkrieg ist ein perfektes Beispiel, dass Skinner Gedanken an der Stelle den Bogen überspannen.

14. Fazit

Die operante Konditionierung ist ein immer noch ein leicht verständliches Modell zur Erklärung von Verhalten. Damit ist sie gleichzeitig ein einfach anzuwendendes und wirkmächtiges Instrument für Lehrer, Therapeuten und vor allem Tiertrainer und Hundehalter.

Dabei sollte aber übersehen werden, dass Lebewesen nicht nur aus messbarem Verhalten bestehen. Vielmehr laufen im Inneren viele Prozesse ab, die teilweise zwischenzeitlich wissenschaftlich erforschbar und messbar sind. Aber selbst, wenn hier noch nicht alle Zusammenhänge klar erforscht sind, sie Gefühle, Instinkte und innere Bedürfnisstruktur nicht zu vernachlässigen.

- Lerntheorie I: Die wissenschaftlichen Grundlagen modernen Hundetrainings – Pawlow, Skinner & Co

- Lerntheorie II: Clicker- & Targettraining, Shaping & Chaining, Capturing & Co als angewandte Wissenschaft

- Lerntheorie III: Der Kurzüberblick über die Trainingsmethoden der modernen Hundeerziehung

- Wilderei durch den Hund – kein Kavaliersdelikt

- Das Beutefangverhalten von Hunden

- Hundetraining: Das erlernte Entspannen des Hundes mit Entspannungssignalen

Hat dir der Inhalt gefallen? Dann teile ihn doch auch mit anderen: